L’histoire de l’informatique est un voyage fascinant à travers le temps, depuis ses humbles débuts jusqu’aux innovations technologiques les plus étonnantes.

Au cours de ce voyage, nous découvrirons comment cette discipline s’est développée et comment elle a changé nos vies de manière inimaginable. Des machines à calculer mécaniques à supercalculateurs ultra-rapides, plongeons dans le monde merveilleux de l'histoire de l'informatique. Préparez-vous à être émerveillé par chaque étape de cet incroyable voyage !

Histoire de l'informatique

XNUMXe siècle

Au XVIIe siècle, l’histoire de l’informatique fait ses premiers pas. C'est durant cette période que naissent les premières tentatives de création d'appareils mécaniques permettant d'effectuer des calculs mathématiques. L’une des étapes les plus marquantes a été l’invention du boulier amélioré par Blaise Pascal en 1642. Cette machine, connue sous le nom de « Pascaline », permettait l'addition et la soustraction automatiques.

Ce n'est cependant qu'à la fin de ce siècle qu'une avancée significative a été réalisée avec le développement du télégraphe optique par le scientifique français Claude Chappe. Grâce à une série de tours et de signaux visuels codés, ce système permettait de transmettre des messages sur de longues distances à grande vitesse.

Au même moment, une autre invention révolutionnaire voit le jour en Angleterre : la machine à différence proposée par Charles Babbage. Bien qu'il n'ait jamais été construit de son vivant, il a jeté les bases du développement ultérieur des ordinateurs.

Le XVIIe siècle a jeté les bases des avancées futures dans l’histoire de l’informatique. Les idées et les prototypes créés au cours de cette période ont ouvert la voie à une nouvelle ère technologique qui allait radicalement changer notre façon de vivre et de travailler avec les ordinateurs modernes que nous connaissons aujourd’hui.

Siècle XVIII

Le XVIIIe siècle fut une période de grandes avancées dans l’histoire de l’informatique. Durant cette période, d’importantes inventions et découvertes ont vu le jour, qui ont jeté les bases du développement des machines à calculer modernes.

Tout d’abord, nous soulignons les travaux du mathématicien allemand Gottfried Leibniz, qui a conçu une machine mécanique capable d'effectuer opérations arithmétiques. Sa « roue pascale » permettait d’additionner, de soustraire, de multiplier et de diviser efficacement les nombres.

Dans l'industrie textile, Joseph-Marie Jacquard, inventeur français, réalise une innovation révolutionnaire avec la création d'un métier à tisser automatique commandé par des cartes perforées. Ce système pionnier utilisait des motifs codés sur des cartes pour créer des designs complexes sans nécessiter d’intervention humaine directe.

Parallèlement, le XIXe siècle a également vu des avancées importantes dans le domaine de la cryptographie. L’un des noms les plus éminents dans ce domaine est le mathématicien anglais Thomas Bayes, dont les contributions aux probabilités appliquées aux systèmes de cryptage ont jeté les bases des recherches futures dans ce domaine.

Ce ne sont là que quelques exemples qui démontrent comment le XVIIIe siècle a jeté les bases des développements futurs de l’histoire de l’informatique. La combinaison de l’ingéniosité humaine et L'innovation technologique a ouvert la voie vers ce que nous connaissons aujourd'hui comme les ordinateurs modernes. Incroyable !

Dix-neuvième siècle

Le XIXe siècle a été une période de grandes avancées dans le domaine de l’informatique. Au cours de cette période, plusieurs technologies ont été développées et concepts clés qui ont jeté les bases des systèmes informatiques moderne.

Tout d’abord, l’une des plus grandes étapes du XIXe siècle fut l’invention de la machine analytique par le mathématicien britannique Charles Babbage. Cette machine, bien que jamais entièrement construite de son vivant, a posé les bases théoriques de ce que nous connaissons aujourd'hui comme les ordinateurs numériques.

Le progrès technologique de ce siècle contient une innovation majeure qui est le télégraphe électrique. Cette création a été réalisée par Samuel Morse et a permis d'envoyer des messages sur de longues distances à l'aide de signaux électriques. Ces avancées ont ouvert la voie aux futures communications électroniques ainsi qu’aux développements ultérieurs qui y sont liés. avec les réseaux informatiques.

L’introduction et le stockage de données à l’aide de cartes perforées ont marqué une étape importante dans l’évolution de l’informatique. Ces cartes sont devenues un outil fondamental dans le traitement statistique et les recensements, permettant de stocker les informations de manière efficace et fiable.

Le XIXe siècle a été une période transformatrice dans l’histoire de l’informatique, caractérisée par des avancées significatives dans la théorie et la pratique. Ces innovations ont jeté les bases du développement des systèmes informatiques modernes et ont ouvert la voie aux technologies futures qui auraient un impact radical sur notre façon de vivre et de travailler.

Twentieth Century

Le XXe siècle a été une période de progrès technologiques sans précédent dans l’histoire de l’informatique. Durant cette période, de nombreuses technologies que nous utilisons encore aujourd’hui ont été développées et perfectionnées.

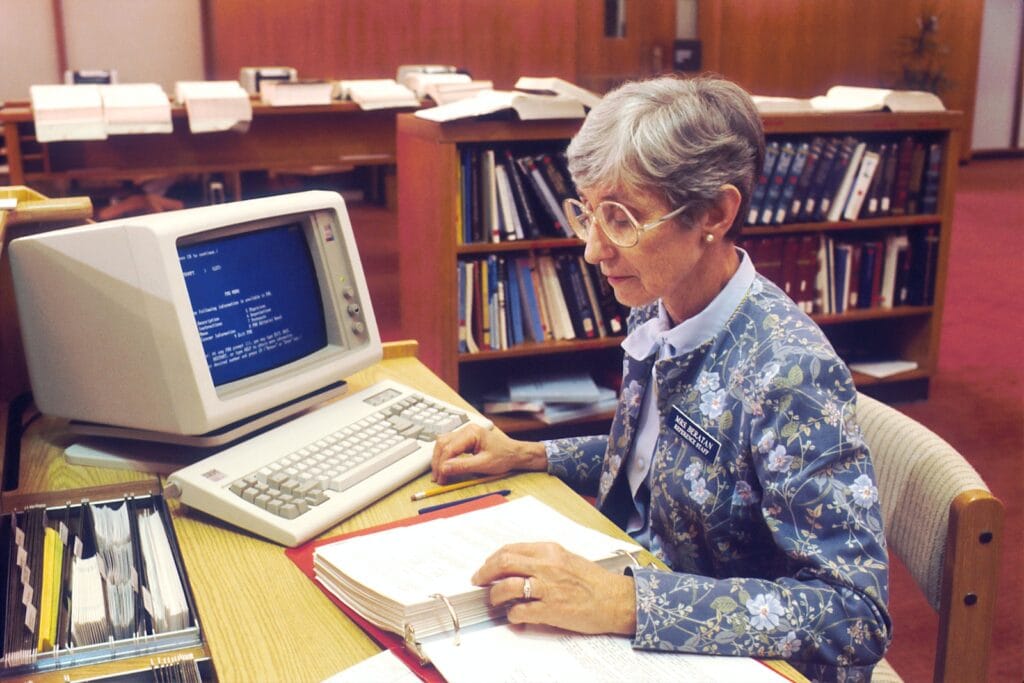

Dans les années 1970, les premiers microprocesseurs sont apparus, permettant le développement de premiers ordinateurs personnels. Ces appareils étaient beaucoup plus petits et accessibles au grand public.

Avec l’arrivée du 21e siècle, nous assistons à une explosion technologique encore plus grande. L’émergence d’Internet a complètement révolutionné notre façon de communiquer et d’accéder à l’information. Les médias sociaux sont devenus une partie intégrante de nos vies et nous avons commencé à porter notre mobiles partout.

Tout au long du XXe siècle, des avancées importantes ont également été réalisées dans des domaines tels que : intelligence artificielle et l' stockage numérique. Les superordinateurs ont commencé à être utilisés pour résoudre des problèmes complexes et effectuer des calculs scientifiques avancés.

Ce ne sont là que quelques exemples marquants de la manière dont l’informatique a évolué au cours du XXe siècle. Chaque décennie a apporté avec elle de nouvelles découvertes et innovations qui ont jeté les bases de ce que nous considérons aujourd’hui comme un élément essentiel de notre vie quotidienne : la technologie informatique.

Années 1970

Tout d’abord, le concept du microprocesseur est apparu grâce à des sociétés comme Intel et AMD. Ces petites puces électroniques ont permis d’augmenter considérablement la vitesse et la capacité de traitement des ordinateurs.

Les années 70 marquent un tournant dans la développement technologique moderne, car c'est à ce moment-là que commencent à être fabriqués des systèmes capables d'interagir avec plusieurs programmes en même temps. Cette innovation donne naissance à des logiciels multitâches, un avantage essentiel de l’informatique contemporaine.

Une autre étape importante a été le lancement depuis le premier disque dur commercialisé par IBM en 1971. Cet appareil révolutionnaire permettait de stocker de grandes quantités de informations numériques et a ouvert la voie à l'avenir Progrès en matière de stockage de masse.

Enfin, c'est au cours de cette période que les premiers réseaux informatiques interconnectés sont également apparus. ARPANET, le précurseur de l’Internet tel que nous le connaissons aujourd’hui, a commencé à s’étendre et à connecter diverses institutions universitaires et gouvernementales.

Les années 70 ont été une décennie remplie d’innovations majeures qui ont laissé une marque indélébile dans l’histoire de l’informatique jusqu’à nos jours.

XXI siècle

Le 21e siècle a été témoin de progrès sans précédent dans le domaine de l’informatique. Au cours des deux dernières décennies, la technologie a connu une croissance exponentielle, transformant radicalement notre mode de vie. L’ère numérique est devenue profondément ancrée dans notre existence et les ordinateurs sont devenus un outil fondamental dans presque tous les secteurs.

L’une des réalisations les plus remarquables du 21e siècle a été l’émergence d’Internet en tant que réseau mondial reliant les gens du monde entier. Cela a ouvert un nouveau monde d’informations accessibles, nous permettant d’accéder à une vaste quantité de données en quelques clics. De plus, le développement constant du matériel et des logiciels a conduit à la création d’appareils plus puissants et plus efficaces.

L’intelligence artificielle a connu des progrès significatifs au cours de ce siècle, avec des applications allant des assistants virtuels aux véhicules autonomes. La capacité de ces machines à apprendre et à s’adapter leur a permis d’atteindre un niveau de sophistication et d’autonomie toujours croissant.

Le cloud s'est avéré être un morceau La clé pour gérer de grandes quantités d’informations, car il permet aux entreprises d’avoir accès à des ressources informatiques sans avoir à investir dans du matériel physique.

Le 21e siècle nous a apporté des avancées incroyables dans l’histoire de l’informatique. De l’Internet à l’intelligence artificielle en passant par le cloud, nous avons été témoins du pouvoir transformateur de cette discipline sur notre vie quotidienne – et ce n’est que le début !

Fond d'ordinateur

L'histoire de l'informatique remonte à de nombreuses années, avec le développement des premiers appareils mécaniques qui cherchaient à faciliter le calcul et le traitement de l'information. Avant l’émergence des ordinateurs tels que nous les connaissons aujourd’hui, il y avait un certain nombre d’antécédents qui ont jeté les bases de leur création.

L’un de ces antécédents était la machine analytique proposée par Charles Babbage au 19e siècle. Cette machine conceptuelle a été conçue pour effectuer des opérations mathématiques complexes et stocker les résultats sur des cartes perforées. Bien qu'il n'ait jamais été construit de son vivant, il a posé les bases théoriques des avancées futures.

Un autre antécédent important est l'invention du télégraphe par Samuel Morse en 1836. Cet appareil permettait la transmission rapide et efficace de messages sur de longues distances grâce au code Morse. Bien qu’il ne s’agisse pas d’un ordinateur à proprement parler, il démontrait comment la technologie pouvait être utilisée pour transmettre des informations.

En 1936, Alan Turing développé ce que nous connaissons aujourd’hui comme « la machine universelle ». Cette idée innovante proposait un système capable de résoudre n’importe quel problème mathématique s’il était doté d’un algorithme approprié. Ses travaux ont posé les bases théoriques du développement ultérieur des ordinateurs électroniques programmables.

Ce contexte a marqué le début du fascinant voyage vers ce que nous considérons aujourd’hui comme un ordinateur moderne. Dans les sections suivantes, nous explorerons chaque génération jusqu'à ce que nous atteignions nos jours où nous vivons entourés de ces machines incroyables qui ont révolutionné nos vies.

générations d'ordinateurs

Première génération (de 1940 à 1952)

La période entre 1940 et 1952 a marqué le début de l’ère informatique, avec la première génération d’ordinateurs qui ont révolutionné le domaine de la technologie. À cette époque, les scientifiques ont commencé à explorer le potentiel des machines électroniques pour traiter l’information.

Ces premiers ordinateurs étaient de véritables géants, occupant des espaces énormes et utilisant des tubes à vide pour effectuer des calculs mathématiques et stocker des données sur des cartes perforées. Bien que leur vitesse soit très lente par rapport aux ordinateurs modernes, ils représentent une avancée significative dans l’histoire de la technologie.

Durant cette période, quelques machines remarquables ont été créées, comme l'ENIAC (Electronic Numerical Integrator and Computer), qui a été utilisé par l'armée américaine pendant la Seconde Guerre mondiale pour effectuer des calculs balistiques de haute précision. Cette machine pionnière a jeté les bases du développement des futures générations d’ordinateurs.

Outre l'ENIAC, d'autres ordinateurs sont apparus tels que l'EDVAC (Electronic Discrete Variable Automatic Computer) et l'UNIVAC I (Universal Automatic Computer). Ces systèmes ont jeté les bases fondements des avancées technologiques futures et a ouvert la voie à une nouvelle ère numérique.

La première génération d’ordinateurs n’était que le début d’une longue évolution qui a conduit aux machines puissantes que nous utilisons aujourd’hui. Nous continuerons d’explorer chaque génération suivante pour mieux comprendre comment nous sommes arrivés au point actuel de l’histoire de l’informatique.

Deuxième génération (de 1956 à 1964)

Au cours de la deuxième génération de l’histoire de l’informatique, qui s’est déroulée entre 1956 et 1964, des avancées importantes ont été réalisées dans le domaine des ordinateurs. À ce stade, les ordinateurs ont commencé à utiliser des transistors au lieu de tubes électroniques, ce qui a permis une augmentation significative de leur vitesse et de leur capacité de traitement.

À cette époque, les progrès technologiques ne se reflétaient pas seulement dans les composants internes, mais également dans l’utilisation de langages de programmation de haut niveau. Cela a rendu les tâches de programmation et d’automatisation beaucoup plus faciles pour les utilisateurs, ouvrant un monde d’opportunités.

Une autre étape importante a été le développement du premier véritable système d’exploitation : IBM OS/360. Ce système d’exploitation permettait à plusieurs programmes de s’exécuter en même temps et gérer efficacement les ressources disponible.

Quant aux applications pratiques, à cette étape, elles étaient principalement utilisées pour des calculs scientifiques complexes et des applications militaires. Cependant, avec de plus en plus d’entreprises intéressées à profiter de ses avantages, de nouvelles applications commerciales ont rapidement émergé.

La deuxième génération a jeté les bases des avancées technologiques futures dans le domaine informatique. Avec améliorations continues Tant au niveau matériel que logiciel, ces machines ont commencé à devenir plus accessibles à un public plus large. L’histoire n’a cessé d’avancer vers de nouveaux horizons !

Troisième génération (de 1965 à 1971)

Au cours de la troisième génération de l’histoire de l’informatique, qui s’est étendue de 1965 à 1971, des avancées technologiques importantes ont eu lieu. L’une des étapes les plus marquantes a été le développement du circuit intégré, également connu sous le nom de puce. Cette innovation a permis de placer les composants électroniques essentiels dans un seul appareil, ce qui a entraîné une réduction significative de la taille et du coût des ordinateurs.

Les derniers systèmes d'exploitation et des versions plus avancées ont commencé à être vues à cette époque. Ces plateformes ont amélioré la maniabilité de l'ordinateur, permettant à l'utilisateur d'effectuer plusieurs tâches simultanément. Dans le même temps, la multiprogrammation est devenue possible, ce qui a ouvert la voie à de nombreuses applications pouvant fonctionner sans conflits entre elles sur des ressources partagées.

Une avancée significative dans l’histoire de l’informatique a été la création de langages de programmation de haut niveau. Ces langages ont révolutionné la façon dont les programmeurs travaillaient, car ils étaient plus intuitifs et plus proches du langage humain. Cela a grandement facilité le processus de programmation et a permis aux développeurs de créer des logiciels plus complexes et sophistiqués.

De plus, durant cette période, on assiste à un boom dans la création d'entreprises dédiées à la fabrication d'ordinateurs commerciaux. Cela a eu un impact significatif sur la disponibilité des ordinateurs, car ils ont cessé d’être exclusivement destinés à des fins scientifiques ou militaires et sont devenus un outil accessible à un plus grand nombre de personnes et d’institutions. Cela a ouvert de nouvelles possibilités d’utilisation des ordinateurs dans une variété de contextes, de l’éducation à l’industrie.

En outre, au cours de cette période, une étape fondamentale s'est produite dans le domaine des systèmes d'exploitation : la invention d'UNIX en 1969 par Ken Thompson et Dennis Ritchie. UNIX était un système d'exploitation révolutionnaire, connu pour son efficacité, sa simplicité et son adaptabilité, caractéristiques qui ont jeté les bases de nombreux futurs systèmes d'exploitation.

La troisième génération a marqué un tournant dans l’évolution historique des ordinateurs, jetant les bases des avancées technologiques passionnantes à venir.

Quatrième génération (de 1972 à 1980)

La quatrième génération d’ordinateurs, développée entre 1972 et 1980, a marqué une avancée significative dans l’histoire de l’informatique. Durant cette période, une transition majeure s'est produite vers l'utilisation de circuits intégrés au lieu de tubes électroniques. Cette innovation a permis de réduire considérablement la taille des machines et d’augmenter leur capacité de traitement.

La génération des années 70 a également été marquée par l'arrivée du microprocesseur Intel 4004. la technologie a révolutionné le monde des ordinateurs personnels lors de son lancement en 1971, il est devenu le premier processeur commercial à succès.

Au cours de la quatrième génération, une amélioration notable de la vitesse et de la capacité de stockage est également devenue évidente. Les nouveaux systèmes d'information Ils pourraient effectuer des tâches plus complexes en moins de temps et gérer de grands volumes d’informations plus efficacement.

L’émergence des logiciels a également constitué une étape importante à cette époque. Ils ont développé des langages comme C++, Pascal et Python, qui ont facilité la programmation et élargi les possibilités de création d'applications plus avancées.

La quatrième génération représente un bond en avant significatif, tant en termes de technologie que de convivialité. Le les ordinateurs étaient plus rapides, plus compact et plus performant que jamais. Cette avancée a ouvert la voie à de nouvelles innovations qui marqueront les étapes historiques suivantes au sein de l' monde numérique.

Cinquième génération (de 1983 à 2019)

La cinquième génération d’ordinateurs, qui s’est étendue de 1983 à 2019, nous a apporté une révolution dans le domaine de la technologie. Au cours de cette période, des progrès significatifs ont été réalisés dans le développement de l’intelligence artificielle et de langages de programmation plus sophistiqués.

L’une des caractéristiques les plus notables de cette génération a été l’introduction du concept de «systèmes experts», qui étaient des programmes capables d’imiter les connaissances humaines et de résoudre des problèmes complexes. En outre, des progrès significatifs ont été réalisés dans le traitement parallèle et distribué, permettant d’exécuter des tâches à grande échelle plus efficacement.

Une autre étape importante de cette période fut la création du premier supercalculateur japonais appelé « Fujitsu VP-2000 », considéré comme l’un des plus puissants et des plus rapides de l’époque. Il y a eu également une miniaturisation et des améliorations supplémentaires dans les appareils portables tels que les ordinateurs portables et mobile.

La cinquième génération d’ordinateurs a vu l’émergence d’Internet, un phénomène qui a radicalement transformé notre façon de communiquer et d’accéder à l’information. La connectivité mondiale est devenue une réalité quotidienne, permettant aux gens du monde entier d’interagir et de partager des informations instantanément.

Cette génération a également marqué un tournant dans l’histoire de l’informatique, car elle a été à l’origine de progrès significatifs tant au niveau matériel que logiciel. Ces avancées technologiques ont jeté les bases d’innovations futures qui allaient continuer à se développer dans les décennies qui ont suivi, façonnant le paysage technologique actuel et ouvrant de nouvelles possibilités de créativité, de collaboration et de progrès.

Sixième génération (de 2019 à un futur proche)

L’histoire de l’informatique a parcouru un long chemin depuis ses débuts au XVIIe siècle jusqu’à nos jours. Chaque génération d’ordinateurs a apporté avec elle des avancées significatives en termes de puissance et de capacité, révolutionnant nos vies et transformant complètement notre façon de communiquer, de travailler et de nous divertir.

La sixième génération, en plein développement depuis 2019 et tournée vers un avenir proche, promet de porter la technologie informatique à des niveaux insoupçonnés. Cette nouvelle ère devrait être marquée par des avancées telles que l’intelligence artificielle avancée, l’informatique quantique et réseaux de neurones artificiels.

Les innovations informatiques permettront de traiter de grandes quantités de données plus rapidement et plus efficacement, ouvrant de nouvelles possibilités dans des domaines tels que le diagnostic médical précis, la conduite autonome et l’exploration spatiale. Ces avancées technologiques ont le potentiel de révolutionner notre façon de vivre et de travailler.

En outre, on s’attend à une croissance significative du traitement des données, conduisant à une plus grande interaction entre les humains et les machines. Les appareils deviendront plus intuitifs grâce à des outils tels que la reconnaissance faciale ou le contrôle des gestes corporels, permettant une plus grande connectivité et une expérience plus naturelle.

Nous vivons une époque passionnante dans l’histoire de l’informatique, avec des avancées technologiques se produisant à un rythme vertigineux. L’évolution de l’informatique est rapide et constante, et nous ne pouvons qu’imaginer les surprises qui nous attendent dans les décennies à venir. Sans aucun doute, l’avenir de la technologie est prometteur et plein de possibilités.

En bref, « L’histoire de l’informatique » est un récit fascinant de l’ingéniosité humaine qui permet de surmonter les barrières techniques et d’amener la technologie vers de nouveaux horizons. Chaque génération d’ordinateurs nous a fourni de nouveaux outils pour étendre nos capacités de traitement, de communication et de divertissement. La sixième génération promet d’être la plus disruptive à ce jour, avec des avancées révolutionnaires en matière d’intelligence artificielle, informatique quantique et les réseaux de neurones artificiels. Ces changements ouvrent un monde de possibilités pour un avenir proche.

Conclusion

L’histoire de l’informatique est un voyage fascinant à travers le temps qui a radicalement changé nos vies. Depuis les premiers appareils mécaniques jusqu’aux avancées de l’intelligence artificielle et de l’informatique quantique, chaque génération d’ordinateurs a marqué des étapes importantes dans le développement technologique. Ces progrès ont permis une plus grande vitesse et une plus grande capacité de traitement, ainsi que la création de nouvelles applications et de nouveaux outils qui ont révolutionné notre façon de travailler, de communiquer et de nous divertir.

L’histoire de l’informatique témoigne de l’ingéniosité humaine et de la quête constante pour surmonter les barrières techniques, et nous laisse des perspectives passionnantes pour l’avenir avec la sixième génération et au-delà. Nous vivons à une époque dominée par la technologie informatique, et nous sommes prêts à être éblouis par chaque nouvelle étape de cet incroyable voyage.

Questions fréquentes

- Quand a commencé l’histoire de l’informatique ?L'histoire de l'informatique remonte au XVIIe siècle, avec l'invention d'appareils mécaniques permettant d'effectuer des calculs mathématiques. L'un des premiers exemples est la Pascaline, conçue par Blaise Pascal.

- Qui a inventé le boulier amélioré connu sous le nom de « Pascaline » ? Blaise Pascal invente la « Pascaline » en 1642. Cette machine à calculer mécanique améliore le boulier traditionnel en permettant l'addition et la soustraction automatiques, facilitant ainsi les opérations arithmétiques en Europe.

- Quelle innovation notable est apparue dans l’Angleterre du XVIIe siècle ? Au XVIIe siècle, Charles Babbage en Angleterre a proposé l'idée de la machine à différences, une innovation qui a jeté les bases théoriques du développement ultérieur des ordinateurs modernes.

- Quelle étape importante s’est produite au XVIIIe siècle en Allemagne ? Au XVIIIe siècle, le mathématicien allemand Gottfried Leibniz perfectionna la « roue de Pascal » en concevant une machine capable d'effectuer non seulement des additions et des soustractions, mais aussi des multiplications et des divisions.

- Qui a révolutionné l’industrie textile au 18e siècle ? Joseph-Marie Jacquard a transformé l'industrie textile avec son invention du métier à tisser automatique en 1804, qui utilisait des cartes perforées pour contrôler le motif de tissage, anticipant les principes de programmation utilisés en informatique.

- Qui a apporté des contributions importantes à la cryptographie au 18e siècle ? Bien que Thomas Bayes soit surtout connu pour son théorème de probabilité, d'autres mathématiciens tels que l'Allemand Friedrich Kasiski ont apporté des contributions significatives au domaine de la cryptographie du XVIIIe siècle.

- Quand sont apparus les premiers microprocesseurs ? Les premiers microprocesseurs, comme l'Intel 4004, sont apparus au début des années 1970. Ces appareils intégraient les fonctions d'un ordinateur sur une seule puce, facilitant ainsi la création d'ordinateurs personnels.

- Quel développement révolutionnaire a eu lieu au 21e siècle ? Au 21e siècle, l’expansion et l’évolution d’Internet ont été révolutionnaires, transformant non seulement notre façon de communiquer, mais aussi notre façon d’interagir avec la technologie dans notre vie quotidienne.

- Quelles applications pratiques ont émergé au cours du XXe siècle ? Au cours du XXe siècle, le développement de l’intelligence artificielle, du stockage numérique et des supercalculateurs a permis des avancées dans la prévision météorologique, les simulations complexes et l’analyse de big data.

- Quels ont été les développements clés des années 70 ? Les années 70 ont vu la naissance du microprocesseur, l’introduction des logiciels multitâches et le lancement du premier disque dur commercial, qui a stimulé l’informatique personnelle et le stockage de données.

- Quelle étape importante a marqué la troisième génération d’ordinateurs ? La troisième génération d'ordinateurs a été marquée par l'utilisation de circuits intégrés, qui ont permis une efficacité accrue et une taille réduite des ordinateurs, ainsi que par l'introduction de systèmes d'exploitation plus sophistiqués.

- Quelles avancées ont marqué la quatrième génération d’ordinateurs ? Dans la quatrième génération d'ordinateurs, l'introduction du microprocesseur et les améliorations des langages de programmation de haut niveau tels que C et Java sont apparues, facilitant la création de logiciels plus complexes et polyvalents.

- Quelles ont été les avancées les plus notables de la cinquième génération d’ordinateurs ? La cinquième génération d’ordinateurs s’est distinguée par des avancées en matière d’intelligence artificielle et de technologies de traitement parallèle et distribué, qui ont permis le développement d’applications plus efficaces et plus puissantes.

- Qu'est-ce qui caractérise la sixième génération d'ordinateurs ? La sixième génération d’ordinateurs devrait être dominée par les avancées de l’intelligence artificielle avancée et de l’informatique quantique, avec des applications potentielles dans des domaines aussi divers que le diagnostic médical et l’exploration spatiale.

- Quel est l’impact de l’histoire de l’informatique sur notre vie quotidienne ? L’informatique a révolutionné de nombreux aspects de la vie moderne, de la communication mondiale et de l’accès instantané à l’information aux avancées significatives dans des domaines tels que la médecine, la science et l’éducation.