- Los deepfakes son contenidos audiovisuales generados por IA que amenazan la privacidad, la reputación y la confianza pública.

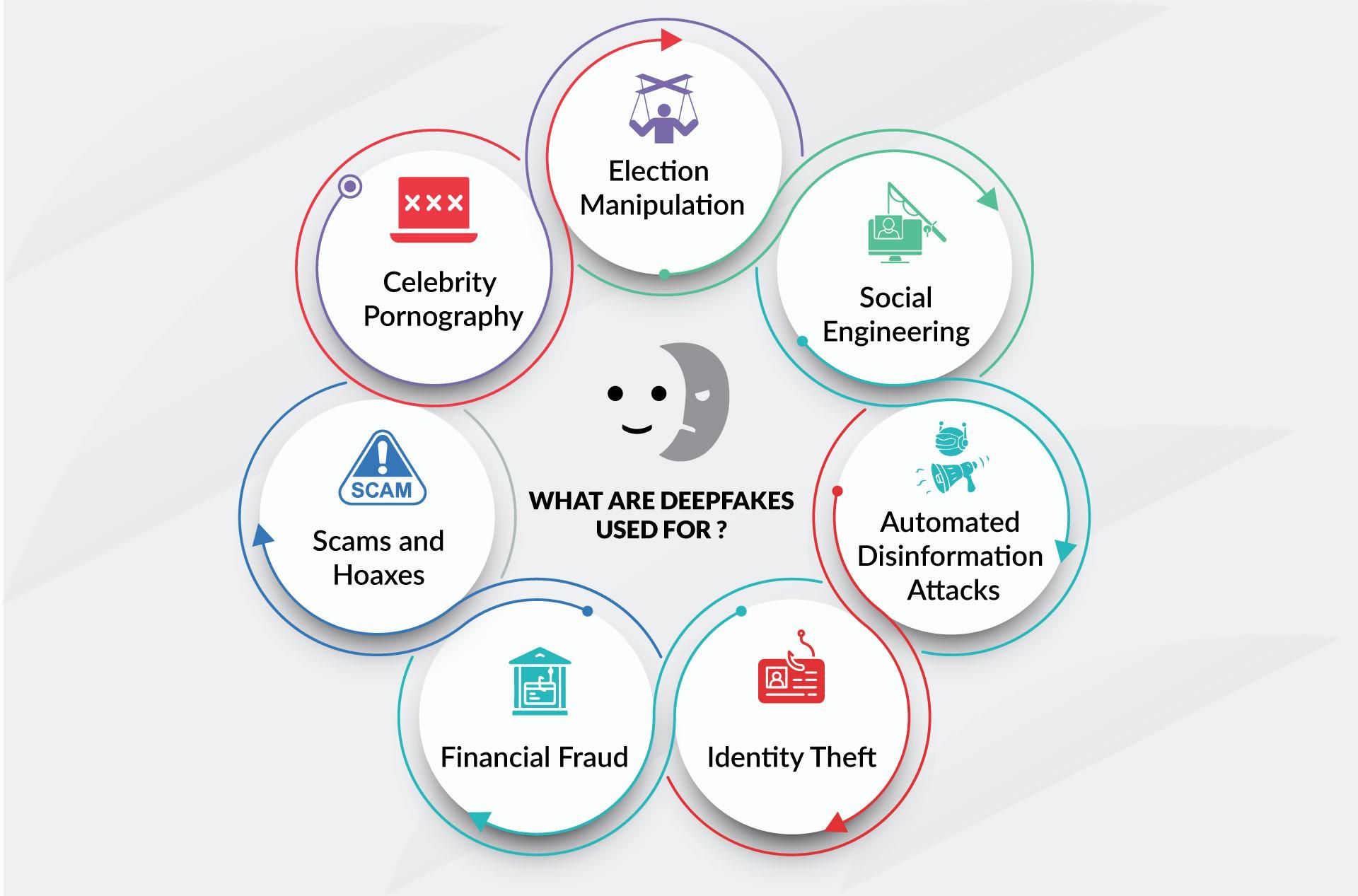

- Su impacto abarca desde el acoso y la pornografía no consentida hasta el fraude corporativo y la manipulación política.

- El marco legal español y europeo ya ofrece herramientas para perseguir usos dañinos, aunque la tecnología avanza muy rápido.

- La defensa exige combinar detección técnica, protocolos organizativos y formación en pensamiento crítico y ciberseguridad.

Los deepfakes han dejado de ser una curiosidad de Internet para convertirse en uno de los retos más serios de la era digital. Vídeos, audios e imágenes manipuladas mediante inteligencia artificial pueden hacer que veamos a alguien decir o hacer algo que jamás ocurrió, con un realismo que, en muchos casos, engaña incluso a ojos expertos. Y esto no solo afecta a famosos o políticos: cualquiera con presencia en redes puede convertirse en objetivo.

Este fenómeno combina tres ingredientes muy peligrosos: tecnología potente, facilidad de uso y enorme capacidad de difusión. El resultado es un cóctel perfecto para la desinformación, el fraude económico, el acoso y la erosión generalizada de la confianza en lo que vemos y oímos. Vamos a desgranar, con calma y en detalle, qué son exactamente los deepfakes, cómo se crean, qué riesgos plantean para personas, empresas e instituciones, qué dice la ley y qué medidas reales podemos tomar para defendernos.

Qué son los deepfakes y por qué importan

El término deepfake surge de la combinación de deep learning (aprendizaje profundo) y fake (falso). Hace referencia a cualquier contenido audiovisual —vídeo, imagen o audio— generado o manipulado por algoritmos de inteligencia artificial generativa para que parezca auténtico. No hablamos de meros filtros o retoques, sino de reconstrucciones completas de rostros, gestos o voces que imitan de forma muy precisa a una persona real.

Con herramientas hoy en día accesibles, incluso gratuitas, es posible superponer la cara de alguien sobre el cuerpo de otra persona, clonar su voz o recrear escenas que nunca han sucedido. El avance de las redes neuronales y de las GAN (redes generativas adversarias) ha hecho que el nivel de realismo se dispare, complicando mucho la distinción entre contenido verídico y manipulado.

Los deepfakes se consideran ya una evolución de las fake news: si antes se manipulaba el texto o la foto, ahora se genera un falso vídeo o un audio creíble que impacta mucho más a nivel emocional y cognitivo. Nuestro cerebro tiende a confiar más en lo que “ve y oye” que en un simple titular, lo que multiplica su poder de persuasión.

Aunque esta tecnología existe desde finales de los 90, saltó a la fama en 2017 cuando un usuario de Reddit empezó a publicar contenido pornográfico falso con el rostro de actrices conocidas. Desde entonces, su uso se ha extendido enormemente, tanto en el ámbito del ocio como en contextos claramente maliciosos.

Cómo se crean los deepfakes: la parte técnica sin tecnicismos

Detrás de un deepfake hay sistemas de aprendizaje automático que analizan miles de imágenes, fotogramas o fragmentos de audio. El proceso típico con rostros sigue dos grandes pasos: codificación y decodificación. Primero, un algoritmo codificador estudia las similitudes entre dos caras y extrae un conjunto de características comunes. Luego, un decodificador reconstruye la imagen objetivo usando las expresiones de la otra persona.

En la práctica, se entrenan dos decodificadores distintos, uno por cada cara. Cuando se introducen los datos de una persona en el decodificador de la otra, obtenemos un vídeo en el que el sujeto A parece realizar los gestos y movimientos del sujeto B. Si se hace bien, el resultado parece una grabación original.

Otra técnica habitual es el uso de redes generativas adversarias (GAN). Aquí intervienen dos redes: una generadora, que fabrica imágenes o fragmentos de vídeo falsos, y otra discriminadora, que intenta distinguir lo falso de lo real. Se enfrentan entre sí miles de veces, mejorando continuamente hasta que el discriminador deja de detectar la trampa con facilidad y el resultado se acerca muchísimo a la realidad.

La mayoría de deepfakes de vídeo se construyen alimentando al algoritmo con grandes conjuntos de imágenes de la persona a imitar. Cuantos más ángulos, gestos y condiciones de luz tenga el modelo, más convincente será el resultado final. Tradicionalmente, por eso, las víctimas solían ser personas muy expuestas mediáticamente, aunque hoy ya basta una sola foto o unos pocos segundos de voz para generar un clon decente.

En el caso de la voz, los sistemas de clonación permiten, a partir de pocos segundos de grabación, reproducir el timbre, acento y ritmo de habla. Combinando síntesis de voz con guiones generados por IA, es posible producir audios en los que la víctima “dice” cualquier cosa que el atacante quiera poner en su boca.

Tipos de deepfakes: imagen, vídeo y voz

Dentro del paraguas de los deepfakes podemos distinguir varias modalidades, según el tipo de contenido manipulado y la técnica empleada. Dos categorías se han popularizado especialmente: deepfaces y deepvoices.

Los llamados deepfaces son aquellos donde se genera o sustituye por completo el rostro de una persona. A partir de múltiples fotografías, el sistema compone caras estáticas tan verosímiles que parecen retratos reales y, después, las encadena en secuencia para crear un vídeo fluido. El objetivo es conseguir que, al verlo, nadie sospeche que está ante una composición artificial.

En paralelo, los deepvoices se centran en la suplantación de la voz. El algoritmo aprende las características vocales de una persona (frecuencia, entonación, pausas, muletillas…) y luego puede leer cualquier texto haciéndolo pasar por esa persona. Este tipo de deepfake es especialmente peligroso en el ámbito corporativo y financiero.

Un ejemplo paradigmático se produjo en 2019: unos ciberdelincuentes clonaron la voz de un CEO para llamar a un alto cargo de su empresa y ordenarle una transferencia urgente de más de 250.000 dólares. El directivo obedeció porque la voz sonaba exactamente como su superior, y el contexto de urgencia era creíble.

Más allá de estas dos categorías, también existen deepfakes híbridos que combinan vídeo, audio y texto generados por IA, de modo que todo el contenido —lo que se ve y lo que se oye— es sintético pero coherente. A medida que la tecnología madura, las fronteras entre unos tipos y otros se difuminan.

Usos legítimos y aplicaciones positivas

Aunque solemos asociar deepfakes con estafas y ciberacoso, la misma tecnología tiene aplicaciones totalmente legítimas y valiosas si se usa con transparencia y consentimiento. En la industria del cine, por ejemplo, se emplea para rejuvenecer actores, recrear personajes fallecidos o doblar diálogos sin perder sincronía labial.

En el ámbito educativo, los modelos generativos permiten adaptar contenidos audiovisuales a múltiples idiomas manteniendo la gesticulación original del ponente. Esto mejora la comprensión, evita la sensación de “doblaje de serie B” y facilita la accesibilidad global de cursos y conferencias.

También se exploran usos en accesibilidad, como la creación de avatares que interpretan lengua de signos de forma personalizada, o voces sintéticas a medida para personas que no pueden hablar. Con el enfoque ético adecuado, la misma tecnología que hoy nos preocupa puede abrir puertas importantes en inclusión digital.

El gran reto no es tanto la herramienta en sí, sino el contexto, el propósito y la transparencia con los que se utiliza. De ahí que las regulaciones europeas recientes insistan en la obligación de etiquetar claramente los contenidos generados por IA para que el público pueda distinguirlos.

Riesgos y amenazas de los deepfakes para la sociedad

El impacto negativo de los deepfakes abarca desde el plano íntimo de una persona hasta la estabilidad política, económica y social. Uno de los peligros más evidentes es la desinformación: vídeos falsos donde se ve a líderes políticos realizando declaraciones incendiarias o reconociendo actos delictivos que nunca han tenido lugar.

Aunque después se desmientan, el daño ya está hecho, porque el impacto emocional del primer visionado suele pesar más que la rectificación posterior. Esto contribuye a polarizar la opinión pública, alimentar teorías conspirativas y debilitar la confianza en los medios y en las instituciones democráticas.

Otro riesgo gravísimo es el uso de deepfakes para acoso, difamación y vulneración de la intimidad. La creación de porno falso con el rostro de mujeres —especialmente políticas, activistas y periodistas— se ha convertido en una forma de violencia digital con consecuencias devastadoras en su reputación, vida personal y salud mental.

Estudios recientes señalan que alrededor del 2,2 % de las personas encuestadas en determinados trabajos académicos se identifican como víctimas de deepfakes íntimos, mientras que un 1,8 % reconoce haber creado o difundido este tipo de contenidos. Aunque las cifras parezcan bajas, reflejan una tendencia preocupante y en crecimiento.

Además, los deepfakes favorecen la aparición de una “crisis de la verdad”: si cualquier prueba audiovisual puede ser fabricada, la sociedad corre el riesgo de asumir que nada es completamente creíble. Este es quizá el impacto más peligroso a largo plazo, porque erosiona la confianza básica necesaria para la convivencia digital y el debate público informado.

Impacto en el fraude y la ciberseguridad corporativa

En el ámbito empresarial, los deepfakes se están convirtiendo en una herramienta de ataque muy eficaz para ciberdelincuentes. No hablamos de ciencia ficción: hay ya numerosos casos de suplantación de directivos mediante vídeo o audio para ordenar transferencias, solicitar datos sensibles o dar instrucciones estratégicas falsas.

Uno de los escenarios más habituales se integra en . Además del clásico correo fraudulento, el atacante incorpora un vídeo o audio deepfake del CEO o del CFO reforzando la urgencia de la petición. La víctima, al ver o escuchar a su “jefe”, baja la guardia y ejecuta la orden.

También se utilizan deepfakes en ingeniería social avanzada. Por ejemplo, se envía a un despacho de abogados un vídeo aparentemente rutinario en el que un socio reclama la firma urgente de contratos o el acceso a determinados documentos. El contexto es verosímil, la imagen y la voz cuadran, y el sistema de verificación se basa únicamente en “reconocer la cara”.

En entornos de trabajo remoto, cada vez más habituales, los atacantes se cuelan en videollamadas haciéndose pasar por miembros del equipo. Mediante avatares generados por IA, participan en reuniones, solicitan acceso a sistemas internos o presionan para obtener información reservada. La suplantación puede pasar desapercibida si el comportamiento no resulta demasiado extraño.

Todo esto supone un desafío directo para los sistemas de seguridad basados en reconocimiento facial o de voz. Estudios recientes indican que pequeños ajustes en sombras, desenfoques inteligentes o ruido adversario pueden reducir drásticamente la eficacia de los detectores biométricos, permitiendo que un rostro falso supere el control de acceso.

Desafíos para la detección: por qué no basta con un antivirus

Detectar deepfakes no es tan sencillo como instalar un software y olvidarse. Los modelos de detección actuales se enfrentan a un problema clave: su capacidad de generalización es limitada. Suelen entrenarse con ciertas técnicas y estilos de manipulación y, cuando aparece un nuevo algoritmo generador, pierden eficacia.

Además, los atacantes pueden introducir perturbaciones adversarias diseñadas específicamente para engañar a los detectores. Es decir, añaden ruido imperceptible al ojo humano, pero que confunde a los sistemas forenses y hace que el contenido manipulado pase los filtros como si fuera auténtico.

A esto se suma el reto de la escalabilidad. Las plataformas y redes sociales reciben cada día cantidades ingentes de vídeos y audios, por lo que analizar en profundidad cada pieza es prácticamente imposible. Muchas se ven obligadas a recurrir a muestreos, análisis superficiales o sistemas automáticos que, a veces, fallan.

Por tanto, hoy por hoy no existe una “bala de plata” contra los deepfakes. La defensa requiere una combinación de técnicas: análisis de metadatos, examen de artefactos visuales o sonoros, redes neuronales entrenadas para detectar patrones sutiles y, muy importante, formación y sentido crítico de los usuarios.

El propio avance de la IA obliga a actualizar de manera continua los modelos de detección. Cada nueva generación de herramientas generativas obliga a revisar y reentrenar los sistemas defensivos, lo que plantea un juego del gato y el ratón permanente entre atacantes y defensores.

Marco legal: cómo responden España y la Unión Europea

A nivel jurídico, los deepfakes no siempre aparecen como delito específico, pero su uso dañino encaja en varios tipos penales y normativas ya vigentes. En España, el Código Penal ofrece diferentes vías de protección frente a suplantaciones y vulneraciones de la intimidad.

El artículo 197 y siguientes protegen el derecho a la intimidad y a la propia imagen, sancionando la obtención, uso o difusión de imágenes o grabaciones de carácter íntimo sin consentimiento, incluso si han sido manipuladas digitalmente. Un deepfake sexual difundido sin permiso puede considerarse delito contra la intimidad.

El artículo 401 tipifica la suplantación de identidad, que se puede aplicar cuando un deepfake se utiliza para hacerse pasar por otra persona, por ejemplo, para engañar a terceros o cometer fraudes. Los artículos 208-210 regulan injurias y calumnias, aplicables si el contenido falso daña gravemente el honor o la reputación de la víctima.

Los artículos 248 y 249, relativos a la estafa, cubren supuestos en los que se usan voces o rostros alterados para obtener un beneficio económico ilícito. En estos casos, el deepfake es el medio empleado para cometer el delito, aunque no se tipifique como ilícito independiente.

En paralelo, la Ley Orgánica 3/2018 (LOPDGDD) y el Reglamento General de Protección de Datos (RGPD) protegen los datos personales, incluidos los biométricos como rostro o voz. Utilizar la imagen o la voz de alguien en un deepfake sin su consentimiento puede constituir una infracción grave de protección de datos, con sanciones administrativas y posibles responsabilidades civiles o penales.

La Ley Orgánica 1/1982, sobre el derecho al honor, a la intimidad y a la propia imagen, permite a la víctima demandar civilmente a quien difunda un deepfake que atente contra su dignidad o reputación, solicitando retirada del contenido, indemnización por daños y medidas cautelares urgentes para frenar su difusión.

En el plano europeo, el AI Act (Reglamento de Inteligencia Artificial de la UE) exigirá que los contenidos generados mediante IA, incluidos los deepfakes, se identifiquen claramente como tales. Por su parte, el Digital Services Act (DSA) obliga a plataformas y servicios digitales a reaccionar con rapidez ante contenidos falsos, difamatorios o que vulneren derechos fundamentales.

Además, algunos gobiernos —incluido el de España— han comenzado a tipificar de forma más específica delitos ligados a deepfakes sexuales y grooming, reforzando la protección penal frente a la pornografía no consentida generada con IA y el abuso a menores mediante manipulaciones audiovisuales.

Riesgos específicos para menores, mujeres y colectivos vulnerables

Los deepfakes no afectan por igual a todo el mundo. Los datos apuntan a que mujeres, menores y determinados colectivos públicos soportan una parte desproporcionada del impacto, especialmente en el ámbito del contenido íntimo sin consentimiento.

Informes recientes indican que una parte significativa de los deepfakes identificados en la red tienen carácter pornográfico y se centran en mujeres, muchas de ellas figuras públicas. Esto se traduce en campañas de acoso, chantaje y descrédito, con un fuerte componente de violencia de género digital.

Algunos estudios y reportajes estiman que uno de cada cinco jóvenes en España afirma haber sufrido algún tipo de experiencia relacionada con deepfakes durante la infancia o adolescencia, ya sea como víctima directa, espectador o participante. Esta exposición temprana aumenta el riesgo de normalizar prácticas de acoso y sextorsión.

Para la Criminología y el sistema judicial, los deepfakes suponen un quebradero de cabeza adicional: podrían llegar a presentarse como “pruebas” en procesos judiciales, dificultando la labor de jueces, fiscales y peritos para determinar la autenticidad de los materiales.

La situación también plantea problemas serios en el ámbito de la seguridad personal y de la ciberseguridad pública, ya que la biometría de control de accesos basada en rostro o voz podría volverse cada vez menos fiable si no se desarrolla en paralelo mecanismos robustos de detección de contenido sintético.

Más allá de los daños individuales, la proliferación de deepfakes contribuye a un clima de desconfianza generalizada en la información digital. Si cualquier vídeo o audio puede ser falso, se instala la idea de que “nada es seguro” y, al final, mucha gente deja de intentar diferenciar entre lo verdadero y lo manipulado.

Esta fatiga informativa es especialmente peligrosa porque allana el terreno para campañas de desinformación y manipulación masiva. Los ataques de desinformación que combinan noticias falsas con deepfakes audiovisuales pueden influir en elecciones, referéndums, decisiones de inversión y relaciones internacionales.

Las redes sociales actúan como acelerador de este proceso. Un contenido falso pero impactante puede viralizarse en cuestión de minutos, mientras que la verificación y las rectificaciones llegan mucho más tarde y con menor alcance. Este desfase juega claramente a favor de quienes utilizan la IA generativa con fines maliciosos.

Las grandes plataformas —Facebook, X (antes Twitter), Google, etc.— han anunciado medidas para limitar la difusión de deepfakes dañinos, desde prohibiciones explícitas hasta sistemas de etiquetado y eliminación rápida. Sin embargo, la magnitud del problema y la rapidez con la que evoluciona la tecnología hacen que la respuesta sea siempre parcial.

El riesgo más profundo es que estos fenómenos contribuyan a desgastar el pensamiento crítico de la ciudadanía. Si “todo puede ser mentira”, se vuelve más sencillo sembrar dudas, propagar teorías extremas y socavar la confianza en medios, instituciones e incluso en el propio sistema democrático.

Estrategias tecnológicas y organizativas para defenderse

Frente a un problema tan complejo, la respuesta tiene que ser igualmente multidimensional. En el plano técnico, se están desarrollando algoritmos de detección basados en IA que buscan pequeñas incoherencias en los vídeos: errores en la sincronización labial, parpadeos poco naturales, artefactos de compresión, piel excesivamente lisa o bordes borrosos en la zona del rostro.

Otra línea de trabajo consiste en proteger el contenido “en origen”, insertando marcas de agua invisibles o metadatos verificables que acreditan que un vídeo o una foto son auténticos. Estas marcas pueden ayudar después a diferenciar materiales originales de copias manipuladas, siempre que haya un estándar aceptado y herramientas para validarlas.

En entornos corporativos, cada vez cobra más fuerza la autenticación multifactorial ampliada. Es decir, no confiar exclusivamente en la imagen o la voz de una persona, sino combinarla con otros factores: geolocalización, patrones habituales de uso, confirmaciones por canales alternativos (SMS, aplicaciones seguras) o códigos de un solo uso.

También se recomienda implantar protocolos claros para operaciones sensibles, como las transferencias bancarias o los cambios de credenciales. Por ejemplo, establecer que ninguna orden económica importante se ejecuta solo por correo o videollamada, sino que requiere siempre una verificación adicional por un canal distinto.

Por último, la formación continua es clave. Las organizaciones que realizan simulacros de phishing y deepfakes —enseñando a su plantilla a detectar señales sutiles como desfases de audio, gestos poco naturales o comportamientos fuera de lo común— desarrollan una cultura de seguridad mucho más resistente.

Cómo detectar un deepfake: señales prácticas para el día a día

Desde el punto de vista del usuario, hay varias pistas que pueden ayudar a sospechar que un contenido es falso, aunque no siempre sean definitivas. Una primera recomendación es buscar fallos visuales evidentes: bordes difuminados alrededor de la cara, iluminación incoherente respecto al fondo, movimientos entrecortados o expresiones faciales “raras”.

El parpadeo es otro indicador útil. Muchos deepfakes siguen mostrando patrones de parpadeo poco naturales: ojos demasiado abiertos durante mucho tiempo o parpadeos con un ritmo extraño. Aunque los modelos nuevos están mejorando en este aspecto, sigue siendo un punto débil en muchos casos.

Conviene fijarse también en el cuerpo, el cuello y los hombros de la persona. La mayoría de manipulaciones se centran en el rostro, por lo que el resto del cuerpo puede delatar la falsificación si las proporciones, la postura o los gestos no coinciden con lo esperable para esa persona.

La duración del vídeo puede ser otra pista. Generar un deepfake largo requiere más recursos y aumenta las probabilidades de que aparezcan errores, así que muchos contenidos manipulados son relativamente cortos y se centran en una frase o escena muy impactante. Un clip brevísimo con un mensaje explosivo debería ponernos en guardia.

Por último, es crucial analizar el contexto y el origen de la grabación. ¿Quién lo ha difundido primero?, ¿aparece en medios solventes o solo en cuentas anónimas?, ¿hay otras fuentes independientes que confirmen lo que se ve? Reducir la velocidad de reproducción o ver el vídeo fotograma a fotograma puede ayudar a detectar cambios súbitos en el fondo, la alineación de la cara o el interior de la boca (lengua, dientes), zonas donde muchos algoritmos aún fallan.

Educación mediática y cultura de verificación

Ninguna tecnología de detección será suficiente sin una ciudadanía con pensamiento crítico y habilidades básicas de verificación. Organismos como INCIBE y la Oficina de Seguridad del Internauta insisten en la necesidad de estar alerta ante la información que recibimos, analizar los contenidos con detalle y contrastar siempre con fuentes fiables.

Desarrollar el hábito de no compartir nada de forma impulsiva, especialmente si apela a emociones fuertes (miedo, rabia, indignación), es una de las mejores vacunas frente a la viralización de deepfakes y noticias falsas. Pararse unos segundos a preguntar “¿quién gana con que yo crea esto?” puede cambiar mucho las cosas.

La formación en ciberseguridad, investigación online y ciberinteligencia no es solo cosa de especialistas. Comprender cómo operan el phishing, la ingeniería social y los ataques de desinformación ayuda a que cualquier persona reduzca notablemente su superficie de exposición, tanto en su vida privada como profesional.

En el caso de niños y adolescentes, es especialmente importante integrar estos temas en la educación digital y emocional, explicando los riesgos del ciberacoso, la sextorsión y la difusión de imágenes íntimas. Saber que un vídeo puede ser falso, pero que sus consecuencias pueden ser muy reales, marca una gran diferencia.

Del lado de las empresas e instituciones, la inversión en programas de sensibilización que vayan más allá de los “consejos genéricos” de ciberseguridad es ya una necesidad estratégica. Quien no entienda los deepfakes, su impacto y cómo reaccionar ante ellos estará en clara desventaja en el nuevo escenario digital.

Todo apunta a que los deepfakes seguirán multiplicándose en volumen y sofisticación, afectando a la seguridad, la economía, la política y la esfera íntima de millones de personas. Asumir que forman parte del paisaje digital, exigir marcos legales claros, apostar por tecnologías de detección robustas y, sobre todo, cultivar una cultura de verificación y responsabilidad compartida es la mejor manera de que esta poderosa herramienta no se convierta en un arma que desfigure por completo la confianza en nuestra vida online.

Tabla de Contenidos

- Qué son los deepfakes y por qué importan

- Cómo se crean los deepfakes: la parte técnica sin tecnicismos

- Tipos de deepfakes: imagen, vídeo y voz

- Usos legítimos y aplicaciones positivas

- Riesgos y amenazas de los deepfakes para la sociedad

- Impacto en el fraude y la ciberseguridad corporativa

- Desafíos para la detección: por qué no basta con un antivirus

- Marco legal: cómo responden España y la Unión Europea

- Riesgos específicos para menores, mujeres y colectivos vulnerables

- Crisis de confianza y consecuencias sociales a gran escala

- Estrategias tecnológicas y organizativas para defenderse

- Cómo detectar un deepfake: señales prácticas para el día a día

- Educación mediática y cultura de verificación