- ChatGPT genera texto por probabilidad, no por verdad, lo que provoca alucinaciones y errores incluso cuando suena muy convincente.

- Los fallos más habituales incluyen datos inventados, pérdida de contexto, problemas de tono, sesgos y limitaciones de conocimiento reciente.

- La forma de preguntar condiciona enormemente la calidad de la respuesta; prompts vagos, sin contexto ni ejemplos, multiplican los errores.

- Verificación con fuentes fiables, revisión humana y adaptación del estilo son claves para usar ChatGPT con seguridad en entornos profesionales.

Desde que irrumpió a finales de 2022, ChatGPT se ha convertido en la herramienta de moda para escribir textos, resolver dudas o ayudar con tareas técnicas, pero su éxito masivo convive con una realidad incómoda: no es infalible, comete errores y a veces lo hace con mucha seguridad. Millones de personas lo utilizan ya en España, aunque los datos muestran que solo una parte pequeña lo usa a diario, en buena medida porque no termina de generar toda la confianza que cabría esperar.

Muchos usuarios perciben que, aunque es muy útil, ChatGPT a veces inventa datos, se contradice, malinterpreta el contexto o responde como si supiera más de lo que realmente sabe. A esto se suman otros fallos prácticos: saturación del servicio, cambios de opinión en poco tiempo, dificultades para comprender el tono irónico o problemas al razonar de forma matemática o especializada. Conocer estos límites es clave para aprovecharla bien sin caer en la trampa de pensar que “si lo dice la IA, será verdad”.

Por qué ChatGPT se equivoca aunque suene tan convincente

Lo primero que hay que entender es que ChatGPT no está diseñado para “buscar la verdad”, sino para predecir palabras. Es un modelo de lenguaje que, a partir de todo lo que ha visto en su entrenamiento, calcula qué combinación de términos es más probable que encaje después de tu pregunta. Eso significa que da prioridad a la fluidez y a la coherencia aparente, no a la comprobación rigurosa de hechos. Si te interesa ver comparaciones entre modelos similares, consulta las diferencias entre Claude, ChatGPT y Gemini.

Esta forma de funcionar provoca las famosas “alucinaciones” de la IA, es decir, respuestas inventadas que parecen muy sólidas. Puede citar estudios que no existen, mencionar leyes que nunca se aprobaron o detallar casos históricos completamente ficticios, con un tono tan seguro que cuesta dudar. Desde fuera suena como una enciclopedia, pero por dentro solo está extrapolando patrones lingüísticos.

Los expertos que analizan estos modelos insisten en que no debemos caer en el antropomorfismo: ChatGPT no “sabe”, no tiene creencias ni intención, solo genera texto. Por construcción, al ser un sistema generativo, siempre habrá un margen de error, por mucho que sus creadores ajusten los modelos con actualizaciones y entrenamiento por refuerzo.

En ámbitos profesionales —marketing, consultoría, salud, finanzas, análisis de datos— esto tiene una consecuencia directa: si no hay supervisión humana y verificación con fuentes fiables, se corre el riesgo de tomar decisiones sobre datos falsos o interpretaciones erróneas. La herramienta puede acelerar muchísimo el trabajo, pero también amplificar fallos si se usa sin filtros críticos; para entender mejor las perspectivas y riesgos de combinar la inteligencia artificial conviene formarse en gobernanza y controles.

Desconfianza, uso real y límites del conocimiento de ChatGPT

En encuestas realizadas en España, una parte importante de usuarios admite que no se fía del todo de las respuestas de ChatGPT. De hecho, un porcentaje notable menciona la “falta de confianza en las respuestas generadas” como motivo principal para no utilizar la herramienta con más frecuencia. Y no es extraño: cuando ves que acierta mucho, pero de vez en cuando patina con ganas, tiendes a cogerlo con pinzas.

Uno de los puntos que más sorprende a la gente es la limitación temporal del conocimiento. Las versiones clásicas del modelo se entrenaron con datos hasta alrededor de 2021, lo que implica que no conoce bien (o directamente desconoce) acontecimientos recientes, cambios legislativos, novedades tecnológicas o figuras públicas emergentes. Puede “imaginar” una respuesta a partir de patrones anteriores, pero no está consultando en tiempo real qué ha pasado esta semana.

Esta carencia se hace aún más evidente en ámbitos especializados: derecho muy reciente, medicina de frontera, nichos técnicos muy concretos o detalles específicos de la realidad de un país. En esos casos, ChatGPT ofrece respuestas incompletas, superficiales o directamente incorrectas, aunque las envuelva en una redacción impecable.

Por eso, muchos expertos recomiendan usarlo como generador de borradores o plantillas sobre las que trabajar, nunca como única fuente. La idea es clara: que te ahorre tiempo estructurando, resumiendo o dándote ideas, pero que seas tú quien revise, contraste y ajuste el contenido con base en conocimientos propios y fuentes externas contrastadas.

Errores típicos en la forma de responder: de los hechos a la redacción

Más allá de las alucinaciones y las carencias de conocimiento reciente, ChatGPT acumula una serie de errores habituales en la manera en que responde. Algunos son puramente de contenido, otros afectan al estilo del texto o a la comprensión del contexto. Entenderlos ayuda a detectar cuándo conviene desconfiar o pedirle que reformule.

Uno de los fallos más mencionados por especialistas es que puede describir mal hechos verificables. Es decir, equivocarse en cifras, fechas, nombres propios o relaciones causales que se pueden comprobar con una simple búsqueda en una base de datos o en una fuente oficial. El problema se dispara cuando se le piden detalles muy concretos que no aparecen con frecuencia en los datos de entrenamiento.

También son frecuentes las respuestas incompletas, que se quedan a medio camino de lo que le has solicitado. Puede omitir apartados importantes, no seguir el formato exacto que pediste o saltarse matices que eran clave en tu pregunta. A veces esto pasa porque el modelo prioriza lo que interpreta como más relevante y deja fuera el resto.

Otra fuente de problemas es que ChatGPT intenta responder a casi todo, incluso cuando no dispone de suficiente información. En lugar de decir “no lo sé” con claridad, suele generar una respuesta aproximada que suena trabajada. Esto es cómodo para el usuario impaciente, pero peligroso cuando lo que se necesita es precisión y rigor.

A nivel lingüístico, en español también se aprecia que la calidad baja respecto al inglés. Aparecen más fallos gramaticales, errores de concordancia, problemas de puntuación o giros poco naturales. Además, se repiten ciertos “tics” típicos de la IA —estructuras como “No solo… sino que…”, “Desde… hasta…”, abuso de palabras como “emocionante” o “aprendizaje”— que delatan enseguida que el texto está generado por un modelo.

Problemas de contexto, tono y comprensión del lenguaje natural

Un punto especialmente delicado es la dificultad de ChatGPT para captar matices de contexto, cultura o momento histórico. Cuando le planteas preguntas que requieren situarse en una realidad concreta —por ejemplo, una situación política local, una norma social específica o una referencia cultural muy localizada—, tiende a ofrecer respuestas excesivamente globales, ambiguas o fuera de lugar.

Esto se nota, por ejemplo, en respuestas que no encajan con el tono que has pedido. Aunque especifiques que quieres algo irónico, sarcástico o muy coloquial, el modelo suele mantenerse en un registro neutro, educado y algo genérico. Y cuando intenta reproducir sarcasmo o ironía, puede hacerlo de forma torpe, malinterpretando tu intención y contestando algo totalmente ajeno al matiz humorístico que pretendías.

En conversaciones largas aparece otro tipo de fallo: la pérdida de contexto. ChatGPT gestiona un número limitado de tokens (una especie de memoria activa). Cuando la interacción se alarga mucho, parte de lo que se dijo al principio se va quedando fuera de ese “espacio mental” y el modelo empieza a olvidar detalles importantes, a contradecirse o a repetir explicaciones que ya te había dado.

Esto se traduce en contradicciones del tipo “antes me dijiste A y ahora me dices B”, o en respuestas que parecen desconectadas de la conversación previa. Una buena técnica para minimizarlo es pedirle que haga resúmenes periódicos —en pocos puntos— de lo acordado hasta el momento y reutilizar ese resumen como contexto en nuevas preguntas.

Además, el modelo puede ofrecer respuestas rígidas o poco naturales cuando el lenguaje del usuario es confuso o está mal redactado. Si el prompt mezcla muchos temas en una sola frase, carece de signos de puntuación o tiene errores graves de escritura, aumenta la probabilidad de que el chatbot interprete mal la pregunta y te conteste algo que no encaja del todo con lo que querías saber.

Fallos de estilo: textos que “huelen” a IA

Quienes trabajan a diario con redacción digital han identificado una serie de patrones muy repetidos en los textos generados por ChatGPT, hasta el punto de que se han convertido en señales claras de “esto lo ha escrito una IA”. Aunque se pueden corregir fácilmente en una revisión, conviene tenerlos localizados para que tus contenidos no suenen clonados; también existen herramientas como la extensión para evitar contenido generado por ChatGPT y otras IAs que ayudan a detectarlos.

Uno de esos tics es el uso sistemático de estructuras como “No solo… sino que también…”. Son correctas, sí, pero cuando aparecen una y otra vez en un mismo texto, el resultado se vuelve pesado y artificial. Lo mismo ocurre con la combinación “Desde X hasta Y”, que la IA emplea con mucha frecuencia para enumerar rangos de temas, niveles o beneficios.

Otro rasgo típico es el abuso de términos como “emocionante”, “aprendizaje”, “descubrimiento” o “experiencia enriquecedora”. Son palabras válidas, pero cuando se repiten en casi todos los párrafos, el texto acaba sonando genérico, exagerado y poco adaptado al público real. Es mejor sustituirlas por vocabulario más concreto y descriptivo, ajustado a lo que se quiere comunicar.

En los titulares, también se nota el sello de la IA cuando cada palabra comienza con mayúscula, algo habitual en inglés pero extraño en castellano. Lo natural en español es poner mayúscula solo a la primera palabra y a los nombres propios. Corregir eso ayuda mucho a que el contenido parezca escrito por una persona y no por un modelo multilingüe que se guía por convenciones anglosajonas.

Por último, la IA suele producir textos con un tono plano, neutro y poco personalizado. Carecen de muletillas propias, expresiones coloquiales bien colocadas o pequeños guiños de humor que sí introduciría un redactor humano. Ajustar el estilo a la voz de tu marca o a tu manera de expresarte —añadiendo metáforas, chascarrillos suaves o referencias cercanas— es fundamental para que el contenido no parezca un simple “copiar y pegar” del chat.

Errores frecuentes al usar ChatGPT para análisis de datos y tareas técnicas

Cuando se utiliza ChatGPT como asistente para Excel, Power BI, SQL, Python u otras herramientas de análisis de datos, los fallos no solo dependen del modelo, sino también de cómo interactúa el usuario con él. Muchos analistas caen en errores de planteamiento que reducen la calidad de las soluciones que reciben.

Uno de los más habituales es ser demasiado genérico o vago al formular la petición. Frases como “Hazme un análisis”, “Escribe una consulta SQL” o “Ayúdame con Power BI” no aportan casi contexto, así que el modelo solo puede devolver ejemplos básicos, plantillas genéricas o suposiciones que rara vez encajan con el problema real.

Otro error muy común es no proporcionar datos de ejemplo ni explicar la estructura de las tablas. Sin saber qué columnas tienes, qué tipo de datos contienen o cómo se relacionan entre sí, ChatGPT solo puede sugerir código aproximado. En cuanto intentas ejecutarlo en tu entorno, empiezan los errores de nombres de campo, tipos incompatibles o filtros mal planteados.

También es frecuente no indicar el nivel de detalle o complejidad que necesitas. Si eres principiante y solo quieres una explicación paso a paso, el modelo puede devolverte algo demasiado técnico. Y si eres experto y buscas optimización avanzada, puede quedarse en soluciones superficiales. Aclarar tu nivel técnico ahorra muchas idas y venidas.

Por último, muchos usuarios tienden a pedir “todo de golpe” en un único comando kilométrico: dashboards completos, informes mundiales, KPIs, segmentaciones, botones… El resultado suele ser una respuesta interminable, difícil de seguir y complicada de trasladar a la práctica. Es mucho más eficiente dividir el problema en pasos pequeños y trabajar la solución por fases; si necesitas guías prácticas para integrar IA con ofimática, consulta cómo usar la IA en Excel y Word.

Inconsistencias, cambios de respuesta y saturación del servicio

Otro comportamiento que desconcierta es que ChatGPT a veces cambia de respuesta ante la misma pregunta si se la repites pasado un rato. El sentido general suele mantenerse, pero pueden variar detalles, matices o la forma de argumentar. Esto se debe a la propia naturaleza probabilística del modelo: no genera siempre el mismo texto, sino que explora distintas combinaciones plausibles.

Para usos informales esto no suele ser grave, pero en entornos donde se requiere trazabilidad o consistencia —por ejemplo, documentación técnica, respuestas de atención al cliente, informes internos— es importante revisar, estandarizar y, si hace falta, fijar plantillas estables basadas en una revisión humana de las salidas de la IA.

A nivel de servicio, la popularidad de la herramienta también ha generado un problema recurrente: la saturación de los servidores. En momentos punta, el acceso puede estar limitado, las respuestas tardan más en llegar o incluso se producen errores puntuales que impiden continuar la conversación. Aunque las versiones más recientes del sistema intentan manejar mejor la carga, la experiencia no siempre es perfecta.

Además, en algunos contextos se han detectado errores ortográficos, gramaticales y de puntuación, especialmente cuando el prompt es ambiguo, está mal escrito o mezcla varios temas en una misma frase. El modelo hace lo que puede por “adivinar” lo que quieres decir, pero el resultado puede ser un texto extraño, con fallos de forma que exigen una revisión a fondo.

Todo esto refuerza la idea de que no conviene depender ciegamente de una sola conversación con la IA. Si la respuesta no encaja, lo sensato es reformular la pregunta, pedir aclaraciones o solicitar otra versión, en lugar de asumir que la primera salida es la definitiva y correcta.

Errores de percepción del usuario: lo que esperamos (mal) de ChatGPT

No todo son fallos del modelo: una parte importante de los problemas proviene de las expectativas equivocadas de quienes lo usan. Se tiende a proyectar sobre la IA capacidades humanas que no tiene, lo que lleva a malentendidos frecuentes.

Un error muy típico es confundir precisión lingüística con verdad. Como el texto está bien redactado, asumimos que el contenido es correcto. Pero ya hemos visto que la prioridad del modelo es construir frases coherentes, no garantizar la exactitud factual. Esa ilusión de autoridad aumenta el riesgo de tragarse sin filtro datos inventados.

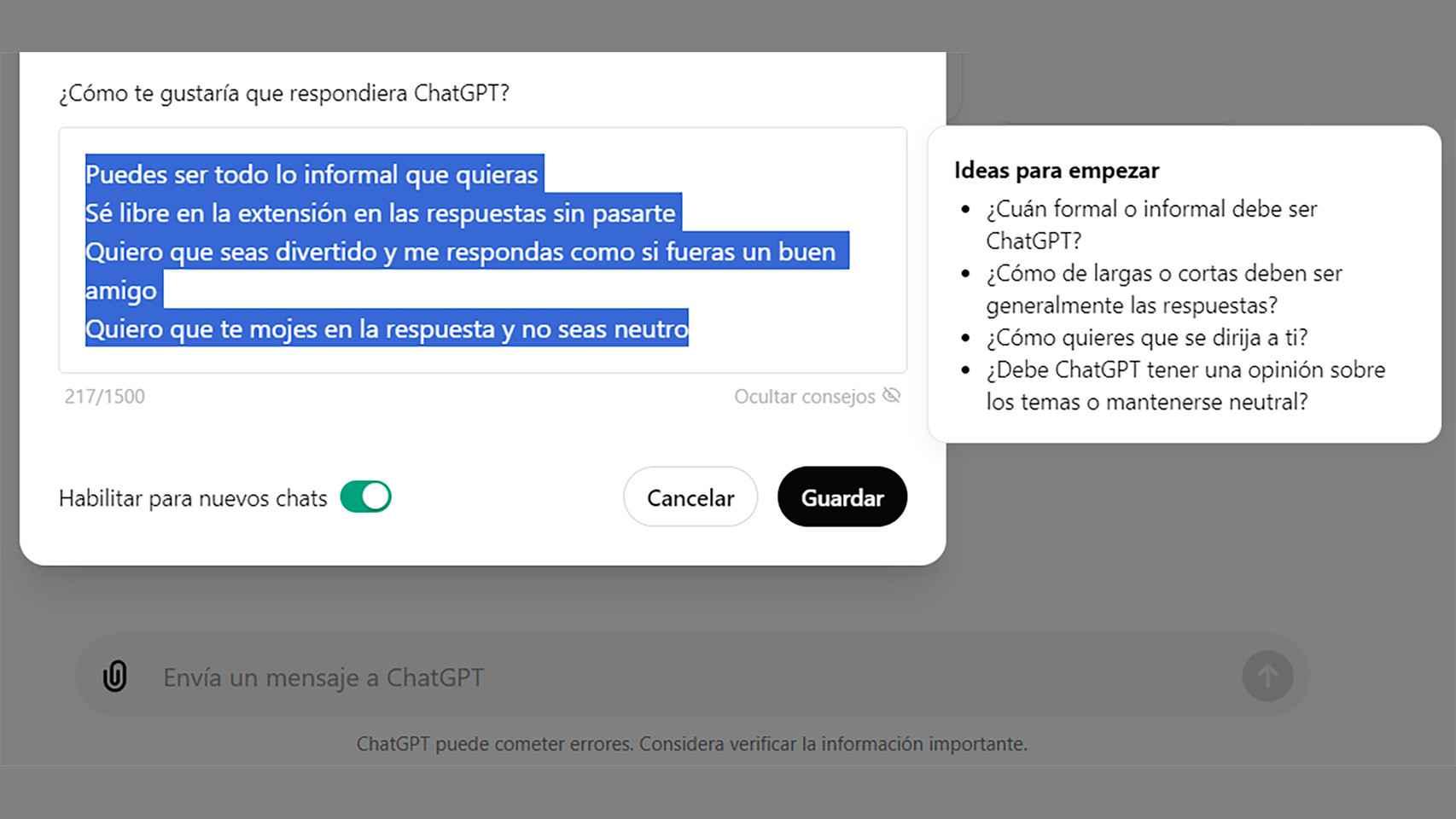

También es habitual menospreciar el impacto de cómo formulamos la pregunta. Cambiar unas pocas palabras en el prompt puede alterar por completo el enfoque de la respuesta: qué información destaca, qué omite, qué interpretaciones propone. Creer que “da igual cómo lo pida, la IA ya me entiende” es otro de los grandes autoengaños; para mejorar resultados, una guía de prompts puede ser de gran ayuda.

Muchos usuarios tienden además a interpretar humanidad donde solo hay forma. Cuando el modelo se disculpa, dice “entiendo tu preocupación” o utiliza expresiones cercanas, parece que empatiza y comprende, pero en realidad solo replica patrones lingüísticos. Esa falsa sensación de persona al otro lado puede llevarnos a confiar demasiado.

Por último, se da por hecho que ChatGPT recordará reglas personales o detalles de otras sesiones, cuando en realidad su memoria está limitada a la conversación actual (salvo funciones específicas de memoria persistente, que también son acotadas). Cada chat nuevo empieza casi de cero, así que hay que volver a explicarle el contexto, las normas de estilo o las restricciones que quieras que respete.

Sesgos, filtros y límites éticos en las respuestas

Otro aspecto poco visible para muchos usuarios es que ChatGPT no es neutral ni completamente libre en lo que responde. Sus salidas están condicionadas por los datos con los que se entrenó —que ya contienen sesgos culturales, de género, geográficos, ideológicos— y por los filtros y reglas que sus creadores han añadido para reducir contenidos problemáticos.

Esto se traduce en respuestas que pueden reproducir estereotipos o sesgos humanos, aunque se intente mitigarlo, y también en mensajes donde el modelo se niega a responder, reorienta la conversación o contesta de forma muy general cuando detecta temas sensibles (salud, política, desinformación, seguridad, etc.). No es un “oráculo”, sino una herramienta acotada por políticas de uso.

Además, al no distinguir bien entre lo que es norma general y lo que es excepción, le cuesta entender cuándo una imagen, un dato o un ejemplo son representativos de la realidad. Esto se ha visto con fallos visuales recurrentes en modelos multimodales: relojes que siempre marcan las 10:10 porque es la hora más frecuente en fotos publicitarias, o dificultades para representar correctamente a una persona escribiendo con la mano izquierda, porque predominan imágenes de diestros.

Ese tipo de errores estructurales muestran que la IA hereda y amplifica la distribución de lo que ve en internet, en lugar de razonar desde cero sobre cómo debería ser el mundo. Por eso no siempre distingue bien entre una rareza y una regla, lo que limita su capacidad de juicio cuando se enfrenta a casos poco frecuentes.

En contextos corporativos, todo esto tiene un impacto claro en reputación, cumplimiento normativo y gestión de riesgos. Un simple contenido sesgado o una recomendación mal planteada pueden escalar rápido en redes sociales, afectar la percepción de marca o incluso chocar con regulaciones de protección de datos, igualdad o publicidad veraz.

Buenas prácticas para minimizar los errores de ChatGPT

Ante este panorama, la solución no es dejar de usar la herramienta, sino aprender a convivir con sus limitaciones y reducir al máximo sus fallos. Hay varias pautas prácticas que ayudan mucho en el día a día, tanto a nivel personal como en entornos profesionales.

La primera es verificar la información importante con otras fuentes fiables, especialmente si vas a publicar, tomar decisiones estratégicas o tratar temas sensibles. Contrastar datos con documentos oficiales, estudios reconocidos o bases de datos especializadas sigue siendo imprescindible; en entornos profesionales, el testing automatizado para modelos de IA puede ayudar a detectar regresiones y errores.

La segunda consiste en mejorar la calidad de tus prompts. Ser concreto, aportar contexto, definir objetivos, indicar el nivel de profundidad y especificar el formato de salida (esquema, tabla, listado, tono, extensión…) cambia radicalmente la utilidad de la respuesta. Cuanto más clara sea tu instrucción, menos margen habrá para que el modelo rellene huecos inventando.

En tercer lugar, es clave desarrollar un espíritu crítico y cierto conocimiento del dominio en el que estás trabajando. Cuanto más sepas tú del tema, más rápido detectarás incoherencias, omisiones o sesgos en lo que devuelve la IA. No se trata de que seas experto en todo, pero sí de que no delegues por completo el juicio en la máquina.

Por último, conviene adaptar y humanizar los textos generados antes de usarlos tal cual. Ajustar el tono a tu voz o a la de tu marca, eliminar muletillas típicas de la IA, revisar ortografía y gramática, y reorganizar la estructura para que fluya mejor marcará la diferencia entre un contenido “robótico” y uno que conecte de verdad con tu audiencia.

Dominar ChatGPT hoy pasa por entender tanto lo que hace bien como lo que hace mal, aprovechar su enorme capacidad para generar ideas y ahorrar tiempo, y a la vez establecer filtros, revisiones y criterios claros para no caer en alucinaciones, sesgos o errores de contexto. Usado con cabeza, es un aliado potentísimo; usado sin control, puede convertirse en una fuente silenciosa de problemas y malas decisiones.

Tabla de Contenidos

- Por qué ChatGPT se equivoca aunque suene tan convincente

- Desconfianza, uso real y límites del conocimiento de ChatGPT

- Errores típicos en la forma de responder: de los hechos a la redacción

- Problemas de contexto, tono y comprensión del lenguaje natural

- Fallos de estilo: textos que “huelen” a IA

- Errores frecuentes al usar ChatGPT para análisis de datos y tareas técnicas

- Inconsistencias, cambios de respuesta y saturación del servicio

- Errores de percepción del usuario: lo que esperamos (mal) de ChatGPT

- Sesgos, filtros y límites éticos en las respuestas

- Buenas prácticas para minimizar los errores de ChatGPT