- Newelle es un asistente de IA open source para GNOME que combina modelos en la nube y locales con alta personalización y control.

- La app integra voz, gestor de archivos, ejecución de comandos, perfiles y extensiones, diferenciándose de simples chatbots web.

- Permite funcionar totalmente offline con modelos y voces locales, reforzando la privacidad a costa de mayores requisitos de hardware.

- Su enfoque modular y su ecosistema (incluido Nyarch Assistant) lo convierten en referencia para la integración ética de IA en el escritorio Linux.

La llegada de los asistentes de inteligencia artificial al escritorio GNOME está cambiando la forma en que muchos usuarios de Linux se relacionan con su sistema. En lugar de abrir siempre el navegador o el IDE para hablar con un chatbot, empiezan a surgir aplicaciones nativas que integran los modelos de lenguaje directamente en el entorno de escritorio, con más control, privacidad y opciones de personalización.

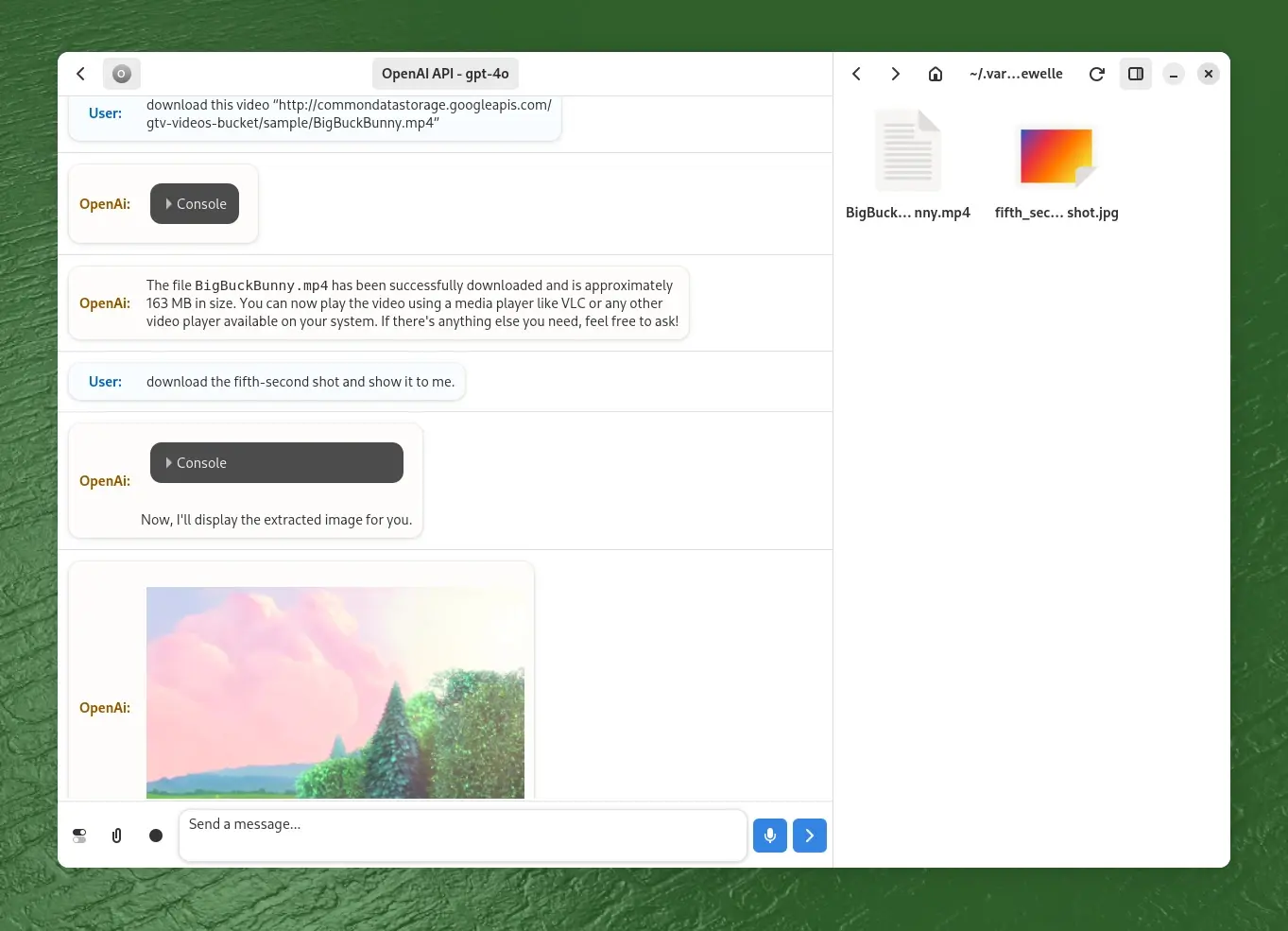

Dentro de este nuevo panorama destaca con fuerza Newelle, un asistente virtual de código abierto pensado para GNOME y para usuarios exigentes, que quieren combinar la potencia de los grandes modelos de lenguaje con la filosofía del software libre. No es un juguete ni un simple wrapper web: es una aplicación GTK4/libadwaita muy completa, con soporte para voz, modelos locales, ejecución de comandos, gestor de archivos y un sistema de extensiones capaz de transformar por completo su comportamiento.

Qué es Newelle y por qué está dando tanto que hablar

Newelle es una aplicación de asistente virtual para GNOME desarrollada con GTK4 y libadwaita, completamente de código abierto, creada por el desarrollador conocido como qwersyk. Su objetivo es ofrecer una interfaz gráfica moderna y nativa para conversar con modelos de lenguaje, tanto remotos (en la nube) como locales que se ejecutan en tu propio equipo.

A diferencia de los asistentes comerciales integrados de forma agresiva en otros sistemas operativos, Newelle no impone un único proveedor de IA ni una forma cerrada de uso. Es, básicamente, una especie de “panel de control” inteligente desde el que puedes conectar servicios como ChatGPT, Gemini, Claude o Groq, o bien trabajar con modelos abiertos a través de Ollama u otras herramientas similares.

La idea no es que le grites desde el salón para que te pida la compra o te traiga antiácidos, sino tener un entorno bien integrado en el escritorio para programar, buscar información, gestionar archivos, analizar documentos o automatizar tareas, todo ello manteniendo el máximo control sobre qué datos salen de tu máquina y qué modelo los procesa.

Newelle se ha ganado un hueco entre los usuarios técnicos de Linux porque combina varias cosas difíciles de ver juntas: una interfaz cuidada para GNOME, un grado de personalización muy alto, soporte para modelos locales, memoria a largo plazo, extensiones programables en Python y una filosofía claramente alineada con el software libre. No intenta ser un clon de los asistentes propietarios, sino una alternativa diferente y mucho más flexible.

Además, el proyecto ha dado pie a variantes como Nyarch Assistant, que le da un giro estético y de personalidad muy marcado, orientado a fans del anime. Todo esto apunta a Newelle no solo como una app concreta, sino como una “plataforma” de asistentes personalizables sobre GNOME.

Modelos de IA compatibles: nube, local y perfiles a medida

Uno de los pilares de Newelle es su compatibilidad con múltiples modelos de inteligencia artificial. No te obliga a usar un solo proveedor, sino que funciona como una capa de interfaz que puede trabajar con:

- Servicios en la nube de terceros como ChatGPT de OpenAI, Gemini de Google o Claude de Anthropic.

- Modelos locales de código abierto que ejecutas en tu propia máquina, de forma especial a través de Ollama u otros backends compatibles.

- Un modelo de demostración alojado por el propio proyecto, pensado para que pruebes la aplicación sin configurar nada, aunque limitado a alrededor de 10 respuestas diarias.

Para trabajar con proveedores comerciales como OpenAI, Google o Anthropic tendrás que aportar tus propias claves de API, ya que Newelle no incluye acceso ilimitado a estos servicios. Esto puede parecer un pequeño obstáculo inicial, pero a cambio te permite elegir la combinación de precios, rendimiento y privacidad que más te convenga.

Los modelos locales ofrecen una ventaja evidente en privacidad y control de datos: las conversaciones no salen de tu equipo y puedes auditar mejor qué modelo estás usando y cómo se actualiza. El peaje está en los recursos: los LLM grandes consumen mucha RAM, requieren GPU potente y suelen implicar descargas de varios gigabytes, de modo que no es la opción ideal para equipos modestos.

Newelle resuelve el caos de configuraciones mediante un sistema de perfiles que te permite guardar diferentes conjuntos de opciones para cada modelo o escenario de trabajo. Así, puedes tener un perfil para un modelo rápido en la nube, otro para un modelo local pesado que usas solo cuando necesitas máxima privacidad y otro específico para tareas de programación o generación de imágenes.

Al cambiar de perfil, la aplicación ajusta de golpe el modelo, los parámetros, la forma de respuesta y las capacidades adicionales (por ejemplo, si ese perfil soporta LaTeX, análisis de documentos o generación de imágenes). Esto facilita muchísimo alternar entre proveedores sin tener que rehacer la configuración cada vez.

Instalación en Linux y variantes disponibles

Newelle se distribuye principalmente a través de Flathub en formato Flatpak, con un paquete oficial. Eso significa que se puede instalar de forma bastante uniforme en la mayoría de distribuciones modernas sin pelearse con dependencias raras.

En una distro típica con soporte para Flatpak basta con ejecutar un comando en la terminal del estilo de:

Comando de instalación: flatpak install flathub io.github.qwersyk.Newelle

Una vez instalado, Newelle se ejecuta aislado dentro del sandbox de Flatpak. Esto es bueno para la seguridad, pero implica que, si quieres que pueda ejecutar comandos del sistema, acceder a ciertas carpetas o interactuar con el bus de sesión, tendrás que ajustar algunos permisos.

Para afinar esos permisos es muy recomendable usar Flatseal, una herramienta gráfica que permite abrir el grifo justo donde hace falta: acceso a directorios concretos, al bus de sesión, a la terminal, etc. Si quieres aprovechar al máximo las funciones avanzadas (sobre todo la ejecución de comandos y la gestión de archivos), conviene dedicar unos minutos a esta configuración inicial.

Además de la versión principal, existe una edición más ligera conocida como Newelle Lite. Esta variante está pensada para arrancar de forma casi instantánea y asociarse a atajos de teclado globales, por ejemplo Ctrl+Espacio, para que puedas invocarla en “modo mini” mientras trabajas en otra aplicación.

Newelle Lite resulta perfecta para equipos con menos recursos o para quienes quieren un asistente rápido siempre a mano, sin desplegar toda la interfaz completa. La filosofía es similar a los launchers flotantes de aplicaciones, pero con un asistente de IA en el centro.

Funciones principales: mucho más que un simple chat

La gracia de Newelle no está solo en que te deje chatear con modelos de lenguaje, sino en todo el conjunto de herramientas que lo rodea para integrarlo en el flujo de trabajo del escritorio GNOME.

En primer lugar, permite conversaciones tanto por texto como por voz. Gracias al soporte para motores de reconocimiento de voz (STT) y síntesis (TTS), puedes mantener un diálogo casi completamente manos libres. Ideal si estás programando, cocinando o simplemente no te apetece teclear.

La aplicación incorpora un sistema de memoria a largo plazo que puede retener cierta información entre sesiones, de forma que no tengas que repetir una y otra vez los mismos datos personales, contexto de proyectos o preferencias. Esta memoria se puede ajustar en la configuración para controlar cuánto y qué se guarda.

Otra función destacada es el editor de mensajes y el historial: puedes modificar entradas anteriores del chat para refinar una conversación, corregir un prompt o experimentar con nuevas instrucciones sin empezar de cero. Es una ayuda muy útil para quien hace mucho “prompt engineering”.

Newelle también soporta formato Markdown y representación de LaTeX con ciertos modelos, lo que viene de maravilla para escribir documentación técnica, notas científicas, fragmentos de código o explicaciones matemáticas directamente en la interfaz del asistente.

En la práctica, esto convierte a Newelle en una herramienta muy cómoda para desarrolladores que quieran pedir generación de código, explicaciones de librerías, documentación rápida o resúmenes de errores sin salir del entorno GNOME.

Gestor de archivos, análisis de documentos y ejecución de comandos

Una de las características que más diferencian a Newelle de los típicos chatbots web es su integración con el sistema de archivos y la terminal. No se queda en responder preguntas: puede manipular tu entorno si se lo permites.

La aplicación incluye un gestor de archivos integrado que se apoya en la IA para organizar y trabajar con documentos. Puedes arrastrar y soltar archivos directamente sobre la ventana de Newelle para que el modelo los analice, resuma, traduzca o genere contenido relacionado.

Por ejemplo, puedes pedirle que lea un PDF técnico largo y te haga un resumen, que extraiga las secciones clave, que prepare tarjetas de estudio o que genere documentación derivada. Algunas de estas funciones dependen de las capacidades del modelo que tengas activo, por lo que no todos los proveedores soportan lo mismo.

En cuanto a la ejecución de comandos, Newelle puede sugerir y lanzar órdenes de terminal directamente. Puedes escribir en lenguaje natural cosas como “crea un directorio llamado ‘Proyectos’ en mi carpeta personal” o “establece una conexión SSH a tal servidor” y dejar que el asistente genere el comando correspondiente y lo ejecute.

Esta función es potentísima, pero lógicamente exige mucha responsabilidad. Antes de abrirle la puerta a ejecutar comandos hay que revisar bien los permisos, entender cómo funciona el sandbox de Flatpak y, si es posible, activar opciones de confirmación para no jugársela con una orden peligrosa.

Combinando gestor de archivos, análisis de documentos y ejecución de comandos, Newelle se convierte en algo más cercano a un “orquestador inteligente” de tu entorno de trabajo que en un simple chat. Puedes automatizar parte de tu flujo diario sin necesidad de escribir siempre scripts a mano.

Extensiones y ecosistema: ampliando el asistente a tu gusto

La extensibilidad es otra de las joyas de la corona de Newelle. El sistema de extensiones permite añadir nuevas funciones, integrar servicios externos o ampliar la compatibilidad con más modelos LLM de forma modular.

Las extensiones suelen escribirse en Python y la comunidad ya ha empezado a compartir módulos para todo tipo de tareas: nuevos motores de texto a voz, conectores con APIs específicas, integración con bases de datos o herramientas de desarrollo, automatizaciones de escritorio, etc.

Entre las extensiones más llamativas está la posibilidad de generar imágenes con Stable Diffusion. En lugar de limitarte al texto, puedes pedirle al asistente que cree ilustraciones o gráficos a partir de descripciones, siempre que el modelo y el backend de imágenes estén correctamente configurados.

El diseño modular de Newelle facilita que otros proyectos lo adapten o hagan forks con su propia personalidad. Un buen ejemplo es Nyarch Assistant, mantenido por el equipo de Nyarch Linux, que reutiliza la base tecnológica pero la envuelve en un estilo muy diferente.

Este enfoque modular convierte a Newelle en una especie de “plataforma de asistentes” dentro del ecosistema GNOME y Linux. En lugar de depender de un único equipo central, quien lo desee puede aportar extensiones, ligeras modificaciones o incluso versiones orientadas a nichos concretos de usuarios.

Nyarch Assistant: la variante con estética anime y enfoque lúdico

Nyarch Assistant es un fork oficial de Newelle que mantiene compatibilidad con sus extensiones y muchas de sus mejoras, pero le da una vuelta completa a la experiencia de usuario, muy orientada a quienes disfrutan de la estética anime y la cultura japonesa.

Este asistente introduce avatares Live2D o LivePNG animados, soporte para “multiwaifu” con cambio dinámico de personaje y una personalidad mucho más desenfadada. La idea básica es convertir al asistente en una especie de “waifu digital” personalizable, tanto a nivel visual como de comportamiento.

Además, Nyarch Assistant se integra con motores de voz como VoiceVox y sistemas de clonación de voz, lo que refuerza esa sensación de personaje acompañante que habla contigo de forma más natural.

Más allá del envoltorio anime, el punto clave es que Nyarch aprovecha la estructura modular de Newelle: los mismos conceptos de perfiles, extensiones, modelos locales y en la nube, pero con una capa estética y de interacción pensada para usuarios que quieren algo más “divertido” que un panel sobrio.

Para quien busca máxima inmersión, la combinación de Live2D, voz sintética y modelos de lenguaje locales o en la nube permite montar un asistente muy personalizado, casi como un personaje recurrente del escritorio que te ayuda con tareas reales de tu sistema Linux.

Privacidad, uso offline y requisitos de hardware

Tanto Newelle como Nyarch Assistant se pueden configurar para funcionar de forma completamente offline, algo que para muchos usuarios de Linux es un requisito casi obligatorio. En este modo, todo se procesa en tu equipo y ningún dato sensible abandona tu máquina.

Para conseguirlo, lo habitual es utilizar modelos locales a través de herramientas como GPT4All u Ollama, siendo Ollama una de las opciones más interesantes por rendimiento y facilidad a la hora de gestionar modelos grandes como Llama 3, Mixtral o similares.

La contrapartida de este enfoque 100 % local es que exige una buena GPU y bastante memoria. Modelos pesados como Llama3-70B, DeepSeek o Mixtral no están precisamente pensados para portátiles modestos; requieren máquinas con recursos serios o, en su defecto, aceptar tiempos de respuesta más lentos.

También se pueden usar motores de voz locales como Vits o VoiceVox, lo que cierra por completo el círculo: reconocimiento de voz, síntesis, modelo de lenguaje y procesamiento de datos, todo corriendo en tu propio hardware sin pasar por servidores de terceros.

Quien quiera hilar aún más fino puede combinar este enfoque con técnicas de virtualización y administración de GPU para optimizar recursos, dedicar tarjetas concretas a los modelos o balancear cargas. Es un terreno algo más avanzado, pero encaja muy bien con el perfil de usuario técnico al que apuntan estas herramientas.

En cualquier caso, la clave está en que tú decides hasta qué punto dependes de la nube. Puedes usar solo modelos locales, solo externos o una combinación de ambos según el tipo de tarea, manteniendo siempre claro qué datos se comparten y con quién.

Comparativa con otras soluciones y alternativas centradas en privacidad

Newelle no es el único jugador en el terreno de los asistentes de IA respetuosos con la privacidad, pero sí uno de los más interesantes cuando hablamos de integración con GNOME y de capacidad de personalización técnica.

En el ámbito de las aplicaciones de escritorio y proyectos libres, se suele comparar con herramientas como NectarGPT. Este último también es de código abierto y hace uso de modelos potentes como GPT-4, pero está más pensado para integrarse con el navegador y la navegación web inteligente, y menos como un “centro de mando” del escritorio Linux.

En el mundo de los asistentes comerciales, el paralelismo habitual aparece con Meta AI u otros bots integrados en redes sociales y plataformas móviles. Son cómodos para usos rápidos, pero están muy atados al ecosistema del proveedor y levantan bastantes dudas sobre qué ocurre realmente con tus datos y tus conversaciones.

Otros servicios centrados en privacidad que han surgido como alternativa a ChatGPT, Copilot o Gemini son:

- DuckDuckGo AI Chat, integrado en el buscador DuckDuckGo, que ofrece varios modelos (incluyendo opciones abiertas) y promete no registrar ni usar tus conversaciones para entrenar modelos.

- AnonChatGPT, que sirve como puerta de acceso anónima a modelos populares sin necesidad de registrarse ni ceder datos personales.

- Leo, el asistente de Brave, incorporado en el navegador y en el buscador de Brave, que prioriza la privacidad y el no rastreo de las consultas.

Frente a estas propuestas, Newelle destaca por estar diseñado desde el inicio para el escritorio Linux, no para el navegador, y por dar al usuario un nivel de control más profundo sobre qué modelos usa, cómo gestiona la memoria, qué extensiones se cargan y qué acceso tiene al sistema.

Para perfiles técnicos y desarrolladores, esta combinación de control, extensibilidad y posibilidad de operar offline coloca a Newelle y sus derivados en una liga propia dentro del ecosistema de asistentes, bastante alejada de los bots cerrados de grandes tecnológicas.

Debate en la comunidad Linux: elección, teclas dedicadas y futuro de la IA en GNOME

El auge de asistentes como Newelle encaja de lleno con un debate más amplio dentro de la comunidad Linux: cómo integrar la inteligencia artificial en el escritorio respetando la libertad de elección del usuario y la privacidad.

Mientras Microsoft impulsa teclas dedicadas como la tecla Copilot en teclados de PC para invocar su asistente, y Google fusiona cada vez más Gemini con Android y sus servicios, muchos usuarios de Linux se preguntan hasta qué punto quieren algo similar en sus distros.

Algunos plantean la posibilidad de tener una “tecla de asistente” en Linux que lance un asistente libre, quizá basado en la futura IA ética que Mozilla está desarrollando, o en proyectos como Newelle. GNOME ya hace un uso intensivo de la tecla “Super” para sus atajos; no es descabellado imaginar algo análogo para un asistente integrado.

En paralelo, se discute si un asistente podría sustituir o complementar tecnologías de indexado y búsqueda como Tracker en GNOME o Baloo y Akonadi en KDE. Un sistema que entienda lenguaje natural y pueda cruzar información de archivos, calendario, correo o notas podría ofrecer búsquedas mucho más ricas… siempre y cuando se respeten los principios de transparencia y control del usuario.

Existe también cierto recelo, especialmente entre quienes critican la sobreexposición de la IA. No falta quien teme que el escritorio se llene de funciones “inteligentes” invasivas o que se pierda el enfoque clásico de herramientas pequeñas que hacen una cosa bien.

En este contexto, Newelle funciona casi como un experimento práctico de cómo podría ser un asistente bien integrado en GNOME sin caer en las prácticas de los grandes vendors: voluntario, desactivable, configurable hasta el extremo y con la opción de no enviar un solo byte a la nube si el usuario así lo decide.

Otros proyectos de asistentes para Linux: ideas y propuestas

Además de Newelle, la comunidad ha empezado a proponer y desarrollar otros asistentes orientados específicamente a Linux. Un ejemplo representativo es el proyecto conceptual Jarvis, pensado como un asistente de voz que traduce lenguaje natural en comandos de terminal.

La idea detrás de Jarvis es que puedas decir cosas como “instala Nginx”, “reinicia el WiFi” o “muestra el uso de RAM”, y que el asistente genere y ejecute los comandos correspondientes: desde sudo apt install nginx -y hasta free -h, pasando por systemctl restart NetworkManager.

Jarvis también pone el acento en un modo educativo, en el que explica paso a paso qué hace cada comando antes de ejecutarlo, ayudando a usuarios novatos a aprender Linux mientras automatizan tareas.

Estas iniciativas demuestran que el deseo de tener asistentes integrados en el escritorio GNOME y en otras interfaces no viene solo de las grandes compañías. La propia comunidad de software libre explora caminos para hacer Linux más accesible para principiantes y más productivo para usuarios avanzados, sin renunciar a sus principios.

En paralelo, siguen apareciendo hilos en foros de GNOME y comunidades de Linux donde se pregunta explícitamente por “clientes de IA nativos para GNOME”, con integración con aplicaciones como Reloj, Calendario o Nautilus. Newelle y proyectos similares responden, al menos en parte, a esa demanda.

La gran incógnita es cómo se combinarán todos estos esfuerzos en el futuro: ¿veremos una API estándar de asistentes para escritorios libres? ¿Se enlazarán con las posibles soluciones de IA de Mozilla? ¿Quedarán como proyectos paralelos que los usuarios instalan opcionalmente, como hoy ocurre con Newelle vía Flathub?

Por ahora, lo que sí está claro es que Newelle encarna bastante bien la forma en la que buena parte de la comunidad Linux quiere que la IA llegue al escritorio: como una opción poderosa, transparente y modulable, no como algo impuesto desde arriba.

Tabla de Contenidos

- Qué es Newelle y por qué está dando tanto que hablar

- Modelos de IA compatibles: nube, local y perfiles a medida

- Instalación en Linux y variantes disponibles

- Funciones principales: mucho más que un simple chat

- Gestor de archivos, análisis de documentos y ejecución de comandos

- Extensiones y ecosistema: ampliando el asistente a tu gusto

- Nyarch Assistant: la variante con estética anime y enfoque lúdico

- Privacidad, uso offline y requisitos de hardware

- Comparativa con otras soluciones y alternativas centradas en privacidad

- Debate en la comunidad Linux: elección, teclas dedicadas y futuro de la IA en GNOME

- Otros proyectos de asistentes para Linux: ideas y propuestas