Línea del tiempo de la historia de la computadora: Un viaje a través de los principales hitos tecnológicos

La línea del tiempo de la historia de la computadora es un fascinante recorrido por los avances tecnológicos que han transformado nuestra sociedad. Desde las primeras máquinas de cálculo hasta los superordenadores modernos, cada paso en esta evolución ha sido crucial para llegar a donde estamos hoy. En este artículo, examinaremos los hitos más significativos que han marcado el desarrollo de estas máquinas extraordinarias, ofreciendo una perspectiva única sobre cómo la tecnología ha moldeado nuestro mundo.

A lo largo de este viaje, descubriremos cómo eran las primeras computadoras y cómo han evolucionado hasta convertirse en los dispositivos potentes y compactos que utilizamos a diario. Analizaremos la historia de la computadora y sus generaciones, revelando los avances clave que impulsaron cada salto tecnológico. Prepárate para una odisea a través del tiempo y la innovación que te dejará maravillado con el ingenio humano y el poder de la tecnología.

Tabla de Contenidos

- Línea del tiempo de la historia de la computadora: Un viaje a través de los principales hitos tecnológicos

- Los orígenes: Del ábaco a las máquinas mecánicas

- La era de las válvulas: ENIAC y las computadoras de primera generación

- Transistores y miniaturización: La segunda generación

- Circuitos integrados: La tercera generación y el camino hacia la PC

- Microprocesadores: La revolución de la cuarta generación

- La era del PC: IBM y la democratización de la informática

- Internet y la World Wide Web: Conectando el mundo

- La revolución móvil: Smartphones y computación ubicua

- Cloud computing y big data: La era de la información masiva

- El futuro: Computación cuántica e inteligencia artificial

- Preguntas frecuentes sobre la línea del tiempo de la historia de la computadora

- Conclusión: línea del tiempo de la historia de la computadora

Línea del tiempo de la historia de la computadora: Un viaje a través de los principales hitos tecnológicos

Los orígenes: Del ábaco a las máquinas mecánicas

La historia de la computadora y sus generaciones tiene sus raíces en instrumentos sorprendentemente antiguos. El ábaco, utilizado hace más de 4000 años, puede considerarse la primera «computadora» de la historia. Este ingenioso dispositivo permitía realizar cálculos complejos con una eficiencia asombrosa para su época, sentando las bases para el desarrollo de herramientas de cómputo más avanzadas.

Siglos después, en 1642, el matemático francés Blaise Pascal dio un paso gigante con la invención de la Pascalina. Esta máquina mecánica podía realizar sumas y restas automáticamente, un logro revolucionario que marcó el inicio de la computación mecánica. La Pascalina no solo era una maravilla de la ingeniería para su tiempo, sino que también demostró que era posible automatizar procesos matemáticos complejos.

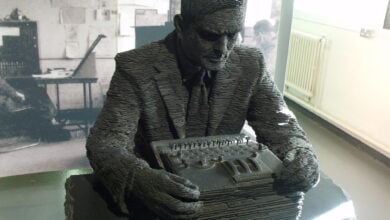

Pero fue Charles Babbage quien realmente anticipó la era de la computación moderna con su máquina diferencial. Diseñada en la década de 1820, esta compleja máquina mecánica estaba pensada para calcular y tabular funciones polinómicas. Aunque nunca se completó en vida de Babbage debido a limitaciones tecnológicas y financieras, su diseño fue un precursor directo de las computadoras modernas.

La visión de Babbage fue tan avanzada que incluso concibió la máquina analítica, un dispositivo que habría sido programable mediante tarjetas perforadas, anticipando conceptos fundamentales de la programación moderna. Ada Lovelace, considerada la primera programadora de la historia, trabajó con Babbage y escribió el primer algoritmo destinado a ser procesado por una máquina, sentando las bases teóricas de la ciencia de la computación.

Estos primeros pasos en la línea del tiempo de la historia de la computadora demuestran cómo la necesidad humana de realizar cálculos complejos impulsó la innovación. Desde el humilde ábaco hasta las sofisticadas máquinas de Babbage, cada invención allanó el camino para los avances tecnológicos que transformarían el mundo en los siglos venideros.

La era de las válvulas: ENIAC y las computadoras de primera generación

La historia de la computadora dio un salto cuántico con la llegada de ENIAC (Electronic Numerical Integrator and Computer) en 1946. Esta máquina colosal, que ocupaba una habitación entera y pesaba más de 27 toneladas, marcó el inicio de la primera generación de computadoras electrónicas. ENIAC utilizaba miles de válvulas de vacío, las cuales permitían realizar cálculos a una velocidad sin precedentes para la época.

¿Cómo eran las primeras computadoras? Enormes, complejas y, por los estándares actuales, increíblemente lentas. Sin embargo, para su tiempo, ENIAC era una maravilla tecnológica capaz de realizar 5000 sumas por segundo, una hazaña impresionante que revolucionó campos como la balística y la meteorología.

Las computadoras de primera generación se caracterizaban por:

- Uso de válvulas de vacío como componentes principales

- Tamaño masivo y alto consumo de energía

- Necesidad de refrigeración constante debido al calor generado

- Programación mediante cableado físico y tarjetas perforadas

- Capacidad de memoria limitada

A pesar de sus limitaciones, estas máquinas tuvieron un impacto profundo en la ciencia y la industria. Por primera vez, los científicos podían realizar cálculos complejos en cuestión de horas en lugar de semanas o meses. Esto aceleró significativamente el progreso en campos como la física nuclear y la aeronáutica.

La era de las válvulas también vio el nacimiento de importantes conceptos en la ciencia de la computación. John von Neumann propuso la arquitectura de programa almacenado, un diseño que permitía almacenar tanto datos como instrucciones en la memoria de la computadora. Este concepto sigue siendo fundamental en la arquitectura de las computadoras modernas.

Aunque la era de las válvulas fue relativamente corta, su impacto en la línea del tiempo de la historia de la computadora fue monumental. Estas máquinas demostraron el potencial de la computación electrónica y sentaron las bases para las innovaciones que seguirían en las décadas posteriores.

Transistores y miniaturización: La segunda generación

La historia de la computadora y sus generaciones dio un giro revolucionario con la invención del transistor en 1947 por los científicos de Bell Labs. Este pequeño dispositivo semiconductor reemplazó a las voluminosas y poco fiables válvulas de vacío, marcando el inicio de la segunda generación de computadoras. El transistor es un elemento clave en la línea del tiempo de la historia de la computadora.

Los transistores ofrecían numerosas ventajas:

- Menor tamaño y consumo de energía

- Mayor fiabilidad y durabilidad

- Generación de menos calor, reduciendo la necesidad de refrigeración

- Posibilidad de fabricación en masa a menor costo

Estas mejoras permitieron la creación de computadoras más pequeñas, rápidas y accesibles. IBM, que ya era un gigante en el campo de las máquinas de tabulación, aprovechó esta tecnología para dominar el mercado de las mainframes. La IBM 1401, introducida en 1959, se convirtió en una de las computadoras más exitosas de su época, con miles de unidades vendidas a empresas en todo el mundo.

La miniaturización facilitada por los transistores también permitió el desarrollo de las minicomputadoras, máquinas más pequeñas y asequibles que las mainframes. El PDP-8 de Digital Equipment Corporation, lanzado en 1965, fue un hito en este sentido, abriendo el camino para que más organizaciones pudieran beneficiarse de la computación.

Paralelamente, la segunda generación vio avances significativos en los lenguajes de programación. FORTRAN, desarrollado por IBM en 1957, se convirtió en el estándar para la programación científica. COBOL, creado en 1959, dominó el procesamiento de datos empresariales durante décadas. Estos lenguajes de alto nivel hicieron la programación más accesible, acelerando el desarrollo de software y aplicaciones.

La era de los transistores no solo mejoró el hardware, sino que también expandió enormemente las aplicaciones de las computadoras. Desde la gestión de inventarios hasta la exploración espacial, las computadoras de segunda generación demostraron ser herramientas versátiles y poderosas, sentando las bases para la revolución digital que estaba por venir.

Circuitos integrados: La tercera generación y el camino hacia la PC

La línea del tiempo de la historia de la computadora experimentó otro salto cuántico con la llegada de los circuitos integrados en la década de 1960. Esta innovación marcó el inicio de la tercera generación de computadoras, caracterizada por una miniaturización aún mayor y un aumento exponencial en la potencia de procesamiento.

El chip de silicio, inventado por Jack Kilby de Texas Instruments y Robert Noyce de Fairchild Semiconductor, permitió integrar múltiples componentes electrónicos en un solo sustrato. Esta tecnología revolucionaria trajo consigo numerosas ventajas:

- Reducción drástica del tamaño de las computadoras

- Aumento significativo de la velocidad de procesamiento

- Mayor fiabilidad y menor consumo de energía

- Costos de producción más bajos

La tercera generación vio el auge de las minicomputadoras, máquinas más pequeñas y asequibles que las mainframes. El PDP-11 de Digital Equipment Corporation, lanzado en 1970, se convirtió en un éxito rotundo, encontrando aplicaciones en laboratorios científicos, entornos industriales y universidades. Estas máquinas más compactas y versátiles allanaron el camino para la informática personal que estaba por llegar.

Durante esta época, también se produjeron avances significativos en software y sistemas operativos. UNIX, desarrollado en los Laboratorios Bell en 1969, introdujo conceptos revolucionarios como la multitarea y la portabilidad entre diferentes plataformas de hardware. Estos avances sentaron las bases para los sistemas operativos modernos que utilizamos hoy en día.

La tercera generación también vio los albores de la informática personal. Aunque aún lejos de las PC que conocemos hoy, máquinas como el Datapoint 2200 de 1970 y el Xerox Alto de 1973 comenzaron a explorar conceptos como interfaces gráficas de usuario y redes locales. Estas innovaciones, aunque limitadas inicialmente a entornos de investigación, sentarían las bases para la revolución de la computadora personal en la década siguiente.

En resumen, la era de los circuitos integrados no solo transformó cómo eran las primeras computadoras en términos de tamaño y potencia, sino que también expandió enormemente su accesibilidad y aplicaciones. Esta generación fue crucial en la democratización de la tecnología computacional, preparando el terreno para la revolución digital que estaba por venir y darle un giro a la línea del tiempo de la historia de la computadora.

Microprocesadores: La revolución de la cuarta generación

La historia de la computadora y sus generaciones alcanzó un punto de inflexión con la llegada de los microprocesadores en la década de 1970. Esta innovación marcó el inicio de la cuarta generación de computadoras, caracterizada por una miniaturización sin precedentes y un aumento exponencial en la potencia de procesamiento. La línea del tiempo de la historia de la computadora sigue su curso.

El Intel 4004, lanzado en 1971, fue el primer microprocesador comercialmente disponible. Este pequeño chip, del tamaño de una uña, contenía 2300 transistores y podía realizar 60,000 operaciones por segundo. Aunque inicialmente diseñado para una calculadora, el 4004 demostró que era posible concentrar todo el poder de procesamiento de una computadora en un solo chip.

Este avance tecnológico pronto dio lugar a las primeras computadoras personales verdaderamente accesibles. En 1977, se lanzaron tres modelos icónicos:

- Apple II: Diseñada por Steve Wozniak y Steve Jobs, se convirtió en un éxito comercial gracias a su interfaz amigable y capacidades gráficas.

- Commodore PET: Una de las primeras computadoras con teclado, monitor y unidad de casete integrados.

- TRS-80: Producida por Tandy Corporation, fue vendida en tiendas Radio Shack, llevando la computación personal al mercado masivo.

Estas máquinas marcaron el inicio de una nueva era en la línea del tiempo de la historia de la computadora. Por primera vez, individuos y pequeñas empresas podían permitirse tener una computadora en casa o en la oficina, lo que democratizó el acceso a la tecnología de una manera sin precedentes.

Paralelamente al desarrollo del hardware, la industria del software experimentó un crecimiento explosivo. Microsoft, fundada por Bill Gates y Paul Allen en 1975, comenzó desarrollando un intérprete BASIC para el Altair 8800, una de las primeras computadoras personales. Pronto, Microsoft se convertiría en un actor clave en la estandarización del software, especialmente con el desarrollo de MS-DOS y, más tarde, Windows.

La cuarta generación también vio avances significativos en los lenguajes de programación y las aplicaciones de software. Lenguajes como C, desarrollado por Dennis Ritchie en los Laboratorios Bell, proporcionaron una poderosa herramienta para el desarrollo de sistemas operativos y aplicaciones. Las hojas de cálculo, los procesadores de texto y los primeros juegos de computadora comenzaron a mostrar el potencial de las PC más allá de las aplicaciones puramente técnicas o científicas.

En resumen, la era de los microprocesadores no solo transformó cómo eran las primeras computadoras en términos de tamaño y potencia, sino que también revolucionó quién podía acceder y utilizar esta tecnología. Esta democratización de la computación sentó las bases para la revolución digital que transformaría todos los aspectos de la sociedad en las décadas siguientes.

La era del PC: IBM y la democratización de la informática

La línea del tiempo de la historia de la computadora alcanzó un hito trascendental con el lanzamiento del IBM PC en 1981. Este evento marcó el verdadero inicio de la era de la computadora personal tal como la conocemos hoy. IBM, gigante de la industria conocido por sus mainframes, decidió entrar en el mercado de las computadoras personales con un diseño que cambiaría el curso de la historia tecnológica.

El IBM PC se distinguió por su arquitectura abierta, una decisión estratégica que tendría consecuencias de largo alcance:

- Hardware estandarizado: IBM utilizó componentes de terceros, como el microprocesador Intel 8088 y el sistema operativo MS-DOS de Microsoft.

- Especificaciones públicas: IBM publicó las especificaciones técnicas del PC, permitiendo a otras empresas crear hardware y software compatible.

- Fácil expansión: El diseño modular permitía a los usuarios actualizar fácilmente componentes como memoria y tarjetas de expansión.

Esta arquitectura abierta desencadenó lo que se conocería como la «guerra de los clones». Empresas como Compaq comenzaron a producir computadoras compatibles con IBM PC, a menudo más baratas o con características mejoradas. Esta competencia aceleró la innovación y redujo los precios, haciendo que las computadoras personales fueran cada vez más accesibles para el público en general.

Paralelamente al hardware, el software experimentó una revolución propia. Microsoft, que había proporcionado el sistema operativo MS-DOS para el IBM PC original, continuó desarrollando su software. En 1985, lanzó la primera versión de Windows, una interfaz gráfica de usuario que se ejecutaba sobre MS-DOS. Aunque inicialmente rudimentaria, Windows evolucionaría para dominar el mercado de sistemas operativos para PC en las décadas siguientes.

La interfaz gráfica de usuario (GUI) representó un cambio paradigmático en cómo los usuarios interactuaban con las computadoras. Inspirada en el trabajo pionero de Xerox PARC y popularizada por Apple con su Macintosh en 1984, la GUI hizo que las computadoras fueran mucho más intuitivas y fáciles de usar para el público en general. Esta accesibilidad amplió enormemente el alcance y las aplicaciones de las computadoras personales.

Durante esta era, las aplicaciones de software se multiplicaron exponencialmente. Programas como Lotus 1-2-3 para hojas de cálculo, WordPerfect para procesamiento de texto y dBase para gestión de bases de datos se convirtieron en herramientas esenciales en oficinas y hogares. Los juegos de computadora también florecieron, con títulos como «King’s Quest» y «Doom» impulsando la adopción de PC entre los usuarios domésticos.

La democratización de la informática tuvo profundas implicaciones sociales y económicas:

- Transformación del lugar de trabajo: Las PC revolucionaron la productividad en oficinas y pequeñas empresas.

- Educación: Las escuelas comenzaron a incorporar computadoras en el aula, preparando a los estudiantes para un mundo cada vez más digitalizado.

- Comunicación: Con la llegada de los módems, las PC abrieron nuevas formas de comunicación digital, sentando las bases para la revolución de Internet.

En resumen, la era del PC, impulsada por el IBM PC y sus clones, marcó un punto de inflexión en la historia de la computadora y sus generaciones. La combinación de hardware estandarizado, sistemas operativos accesibles y una amplia gama de software transformó las computadoras de herramientas especializadas en dispositivos versátiles y omnipresentes, cambiando para siempre cómo trabajamos, aprendemos y nos comunicamos.

Internet y la World Wide Web: Conectando el mundo

La línea del tiempo de la historia de la computadora dio un salto cuántico con el advenimiento de Internet y la World Wide Web. Estos desarrollos no solo revolucionaron la forma en que las computadoras se utilizaban, sino que también transformaron fundamentalmente cómo nos comunicamos, trabajamos y accedemos a la información.

El origen de Internet se remonta a ARPANET, un proyecto del Departamento de Defensa de los Estados Unidos iniciado en 1969. ARPANET fue diseñada como una red descentralizada que podría sobrevivir a un ataque nuclear, pero pronto demostró su valor para la colaboración académica y científica. A medida que más instituciones se conectaban, surgió la necesidad de un protocolo de comunicación estandarizado.

En 1983, ARPANET adoptó el protocolo TCP/IP (Transmission Control Protocol/Internet Protocol), que se convertiría en la columna vertebral de Internet tal como la conocemos hoy. TCP/IP permitió que redes dispares se interconectaran de manera eficiente, sentando las bases para una red global verdaderamente abierta.

Pero fue la invención de la World Wide Web por Tim Berners-Lee en 1989 lo que realmente catapultó Internet a la conciencia pública. Berners-Lee, trabajando en el CERN, desarrolló los protocolos fundamentales de la Web:

- HTML (HyperText Markup Language): Para crear páginas web

- HTTP (HyperText Transfer Protocol): Para transmitir datos entre servidores y navegadores

- URL (Uniform Resource Locator): Para identificar y localizar recursos en la Web

La Web hizo que Internet fuera accesible para el usuario común, proporcionando una interfaz gráfica intuitiva para navegar por la vasta red de información. El lanzamiento del navegador Mosaic en 1993, seguido por Netscape Navigator en 1994, marcó el inicio de la era del navegador web, haciendo que la exploración de Internet fuera fácil y visualmente atractiva.

El impacto de Internet y la Web en la sociedad fue profundo y multifacético:

- Comunicación global: El correo electrónico, los foros en línea y más tarde las redes sociales revolucionaron cómo nos conectamos con otros.

- Acceso a la información: Enciclopedias en línea, bibliotecas digitales y motores de búsqueda pusieron vastas cantidades de información al alcance de todos.

- Comercio electrónico: Empresas como Amazon y eBay pioneras en la venta de productos en línea, transformando el paisaje comercial.

- Educación: El aprendizaje en línea y los recursos educativos abiertos democratizaron el acceso al conocimiento.

- Medios y entretenimiento: Streaming de música y video, noticias en línea y juegos multijugador cambiaron cómo consumimos contenido.

La revolución de Internet también trajo consigo nuevos desafíos y consideraciones éticas. Preocupaciones sobre la privacidad, la seguridad de los datos y la brecha digital se convirtieron en temas importantes a medida que la sociedad se volvía cada vez más dependiente de las tecnologías en línea.

En el contexto de la historia de la computadora y sus generaciones, Internet representa una quinta generación de facto. Aunque no definida por un cambio específico en la arquitectura de hardware, Internet transformó las computadoras de máquinas autónomas en nodos de una red global interconectada, expandiendo dramáticamente sus capacidades y aplicaciones.

La Web continúa evolucionando, con desarrollos como la Web 2.0 (que enfatiza la creación de contenido por parte del usuario y la interactividad) y la Web Semántica (que busca hacer que los datos en línea sean más comprensibles para las máquinas) que siguen empujando los límites de lo que es posible en el mundo digital.

En resumen, Internet y la World Wide Web representan uno de los desarrollos más transformadores en la línea del tiempo de la historia de la computadora. Han redefinido cómo interactuamos con la tecnología y entre nosotros, creando un mundo más conectado e interconectado que nunca.

La revolución móvil: Smartphones y computación ubicua

La historia de la computadora dio un giro revolucionario con la llegada de los smartphones y la computación móvil. Este capítulo marca una transición significativa desde las computadoras de escritorio hacia dispositivos portátiles y altamente personalizados, cambiando radicalmente nuestra interacción con la tecnología. La línea del tiempo de la historia de la computadora sufrió una revolución.

El concepto de teléfono móvil evolucionó rápidamente desde sus inicios en la década de 1970. Los primeros dispositivos eran enormes, costosos y limitados a llamadas de voz. Sin embargo, la miniaturización de componentes y los avances en la tecnología de baterías permitieron el desarrollo de teléfonos cada vez más pequeños y capaces.

El verdadero salto hacia los smartphones comenzó con el lanzamiento del iPhone de Apple en 2007. Este dispositivo revolucionario combinaba:

- Una pantalla táctil de alta resolución

- Un navegador web completo

- Capacidades multimedia avanzadas

- Una interfaz de usuario intuitiva

El iPhone no solo redefinió lo que un teléfono móvil podía hacer, sino que también introdujo el concepto de «apps» o aplicaciones móviles, creando todo un nuevo ecosistema de desarrollo de software.

Poco después, en 2008, Google lanzó Android, un sistema operativo móvil de código abierto. La competencia entre iOS y Android impulsó una rápida innovación en hardware y software, llevando a una proliferación de dispositivos inteligentes con capacidades cada vez más avanzadas.

Los smartphones transformaron rápidamente múltiples industrias y aspectos de la vida cotidiana:

- Comunicación: Mensajería instantánea, videollamadas y redes sociales móviles cambiaron cómo nos conectamos.

- Fotografía: Cámaras de alta calidad integradas convirtieron a millones en fotógrafos amateur.

- Navegación: GPS y mapas en tiempo real revolucionaron cómo nos orientamos y viajamos.

- Comercio: El m-commerce y las aplicaciones de banca móvil transformaron las transacciones financieras.

- Entretenimiento: Juegos móviles, streaming de música y video en cualquier lugar y momento.

La era de los smartphones también vio el surgimiento de la «economía de las apps». Las tiendas de aplicaciones de Apple y Google se convirtieron en plataformas masivas para desarrolladores, creando nuevas oportunidades de negocio y transformando industrias enteras. Aplicaciones como Uber, Instagram y TikTok no solo se convirtieron en gigantes por derecho propio, sino que también cambiaron fundamentalmente cómo interactuamos con servicios y contenido.

Esta revolución móvil llevó al concepto de «computación ubicua», donde la tecnología se integra de manera invisible en nuestro entorno cotidiano. Los smartphones se convirtieron en el centro de un ecosistema más amplio de dispositivos conectados, incluyendo:

- Wearables como smartwatches y dispositivos de fitness

- Asistentes de voz inteligentes

- Dispositivos domésticos inteligentes (IoT)

En el contexto de la línea del tiempo de la historia de la computadora, los smartphones representan una convergencia de múltiples tecnologías: computación, telecomunicaciones, internet y multimedia. Han llevado el poder de procesamiento y la conectividad a nuestros bolsillos, transformando las computadoras de herramientas que usamos en dispositivos que son una extensión integral de nuestras vidas diarias.

La era móvil también ha planteado nuevos desafíos y consideraciones. Preocupaciones sobre la privacidad, la adicción a la tecnología y el impacto en las interacciones sociales se han vuelto temas de debate público. Además, la brecha digital ha adquirido nuevas dimensiones, con el acceso a smartphones y datos móviles convirtiéndose en un factor crucial de inclusión social y económica.

En resumen, la revolución móvil marca un capítulo crucial en la historia de la computadora y sus generaciones. Los smartphones han democratizado el acceso a la tecnología de una manera sin precedentes, llevando el poder de la computación y la conectividad global a las manos de miles de millones de personas en todo el mundo.

Cloud computing y big data: La era de la información masiva

La línea del tiempo de la historia de la computadora ha entrado en una nueva fase con el advenimiento del cloud computing y el big data. Estas tecnologías han transformado no solo cómo almacenamos y procesamos la información, sino también cómo entendemos y utilizamos los datos a escala masiva.

El cloud computing, o computación en la nube, se refiere a la provisión de servicios informáticos a través de Internet. Este modelo ha revolucionado la forma en que las empresas y los individuos acceden a recursos computacionales, ofreciendo:

- Infraestructura como servicio (IaaS): Proporciona recursos de computación virtualizados a través de la red.

- Plataforma como servicio (PaaS): Ofrece entornos de desarrollo y ejecución para aplicaciones.

- Software como servicio (SaaS): Permite acceder a aplicaciones a través de Internet sin necesidad de instalarlas localmente.

Gigantes tecnológicos como Amazon (AWS), Microsoft (Azure) y Google (Google Cloud) han liderado esta revolución, construyendo vastas redes de centros de datos que ofrecen servicios escalables y bajo demanda.

El cloud computing ha traído numerosos beneficios:

- Escalabilidad: Las empresas pueden aumentar o disminuir rápidamente sus recursos según las necesidades.

- Reducción de costos: Elimina la necesidad de mantener infraestructura costosa in situ.

- Accesibilidad global: Los datos y aplicaciones están disponibles desde cualquier lugar con conexión a Internet.

- Innovación acelerada: Permite a las empresas experimentar y desplegar nuevas ideas rápidamente.

Paralelamente, el big data ha emergido como un campo crucial en la era de la información. El término se refiere a conjuntos de datos tan grandes y complejos que las herramientas tradicionales de procesamiento de datos son inadecuadas. El big data se caracteriza por las «3 V»:

- Volumen: Cantidades masivas de datos

- Velocidad: Datos que se generan y procesan rápidamente

- Variedad: Datos en diversos formatos y estructuras

El análisis de big data ha abierto nuevas posibilidades en numerosos campos:

- Negocios: Permite el análisis predictivo y la toma de decisiones basada en datos.

- Ciencia: Facilita el procesamiento de grandes conjuntos de datos en campos como la genómica y la astronomía.

- Salud: Ayuda en la investigación médica y la personalización de tratamientos.

- Ciudades inteligentes: Optimiza la gestión urbana y los servicios públicos.

La confluencia del cloud computing y el big data ha dado lugar a nuevas tecnologías y enfoques:

- Machine Learning y Inteligencia Artificial: El acceso a vastos conjuntos de datos y poder computacional en la nube ha acelerado el desarrollo de algoritmos de aprendizaje automático y AI.

- Internet de las Cosas (IoT): La capacidad de recopilar y procesar datos de innumerables dispositivos conectados ha abierto nuevas posibilidades en automatización y análisis.

- Edge Computing: Complementando el cloud, el edge computing procesa datos cerca de la fuente, reduciendo la latencia y mejorando la privacidad.

Línea del tiempo de la historia de la computadora: Desafíos y la ética:

Esta era también ha traído nuevos desafíos y consideraciones éticas:

- Privacidad y seguridad de datos: La concentración de datos sensibles en la nube plantea preocupaciones sobre su protección.

- Dependencia de proveedores de servicios en la nube: Surge el riesgo de «lock-in» y preocupaciones sobre la soberanía de datos.

- Brecha de habilidades: La demanda de profesionales capacitados en cloud computing y análisis de big data ha crecido rápidamente.

En el contexto de la historia de la computadora y sus generaciones, el cloud computing y el big data representan un cambio paradigmático. Han transformado las computadoras de máquinas individuales en nodos de una vasta red interconectada, capaz de procesar y analizar cantidades de datos previamente inimaginables.

Esta evolución ha llevado a una «democratización» de la computación de alto rendimiento. Pequeñas empresas y startups ahora pueden acceder a recursos computacionales que antes estaban reservados solo para grandes corporaciones y gobiernos. Esto ha acelerado la innovación y ha nivelado el campo de juego en muchas industrias.

Además, el big data ha cambiado fundamentalmente cómo entendemos y tomamos decisiones en diversos campos. Desde la predicción de tendencias de consumo hasta la modelización del cambio climático, el análisis de grandes conjuntos de datos está revelando patrones y conocimientos que antes eran inaccesibles.

Sin embargo, esta era también plantea importantes cuestiones éticas y sociales:

- Privacidad: La recopilación y análisis masivo de datos personales plantea serias preocupaciones sobre la privacidad individual.

- Sesgos algorítmicos: Los algoritmos de machine learning pueden perpetuar o amplificar sesgos existentes si no se manejan cuidadosamente.

- Brecha digital: El acceso desigual a tecnologías de cloud y big data puede exacerbar las desigualdades existentes.

- Seguridad cibernética: La centralización de datos en la nube crea objetivos atractivos para ciberataques.

Mirando hacia el futuro, la convergencia del cloud computing, big data, inteligencia artificial y computación cuántica promete abrir nuevas fronteras en la línea del tiempo de la historia de la computadora. Estas tecnologías tienen el potencial de abordar algunos de los desafíos más apremiantes de la humanidad, desde el cambio climático hasta la cura de enfermedades.

En resumen, la era del cloud computing y big data marca un hito significativo en la evolución de la computación. Ha transformado no solo cómo procesamos y almacenamos información, sino también cómo entendemos e interactuamos con el mundo que nos rodea. A medida que estas tecnologías continúan evolucionando, seguirán redefiniendo los límites de lo que es posible en el mundo digital y más allá.

El futuro: Computación cuántica e inteligencia artificial

La línea del tiempo de la historia de la computadora se extiende hacia un futuro fascinante con el desarrollo de la computación cuántica y los avances en inteligencia artificial (IA). Estas tecnologías emergentes prometen revolucionar no solo cómo procesamos la información, sino también cómo abordamos problemas complejos y entendemos el mundo que nos rodea.

La computación cuántica representa un salto cuántico (literalmente) en el poder de procesamiento. A diferencia de las computadoras clásicas que utilizan bits (0 o 1), las computadoras cuánticas utilizan qubits, que pueden existir en múltiples estados simultáneamente gracias a los principios de la mecánica cuántica. Esto permite:

- Superposición: Un qubit puede representar múltiples estados a la vez.

- Entrelazamiento: Los qubits pueden estar interconectados de manera que el estado de uno afecta instantáneamente al otro, independientemente de la distancia.

Los principios de la computación cuántica ofrecen el potencial de resolver problemas que son intratables para las computadoras clásicas, como:

- Criptografía: Factorización de números grandes, crucial para la seguridad de la información.

- Simulación molecular: Modelado preciso de sistemas químicos para el desarrollo de nuevos materiales y fármacos.

- Optimización: Resolución de problemas logísticos complejos en finanzas, transporte y más.

Aunque aún en sus primeras etapas, empresas como IBM, Google y D-Wave están haciendo avances significativos en la construcción de computadoras cuánticas prácticas.

Paralelamente, la inteligencia artificial ha experimentado un renacimiento con los avances en aprendizaje profundo y redes neuronales. La IA moderna puede:

- Procesar lenguaje natural con una precisión sorprendente

- Reconocer y generar imágenes con un nivel de detalle asombroso

- Jugar juegos complejos a nivel sobrehumano

- Realizar diagnósticos médicos con alta precisión

Los avances en IA están impulsando innovaciones en diversos campos:

- Vehículos autónomos: Transformando el transporte y la logística.

- Asistentes virtuales: Mejorando la interacción humano-máquina.

- Medicina personalizada: Analizando datos genómicos para tratamientos personalizados.

- Creación de contenido: Generando texto, imágenes y música de manera automática.

La convergencia de la computación cuántica y la IA promete abrir nuevas fronteras:

- Algoritmos cuánticos de aprendizaje automático podrían procesar conjuntos de datos masivos con una eficiencia sin precedentes.

- La IA podría ayudar a diseñar y optimizar circuitos cuánticos, acelerando el desarrollo de la computación cuántica.

Sin embargo, estas tecnologías también plantean desafíos éticos y sociales significativos:

- Seguridad: Las computadoras cuánticas podrían romper muchos de los sistemas de encriptación actuales.

- Privacidad: La IA avanzada plantea preocupaciones sobre la vigilancia y el uso indebido de datos personales.

- Desplazamiento laboral: La automatización impulsada por IA podría transformar radicalmente el mercado laboral.

- Sesgos y equidad: Garantizar que los sistemas de IA sean justos y no perpetúen prejuicios existentes.

Mirando hacia el futuro, la historia de la computadora y sus generaciones parece estar entrando en una nueva era de posibilidades casi ilimitadas. La combinación de computación cuántica, IA avanzada, y tecnologías emergentes como la neurotecnología y la computación biológica, podría redefinir completamente nuestra relación con la tecnología.

Estas tecnologías tienen el potencial de abordar algunos de los desafíos más apremiantes de la humanidad, desde el cambio climático y la cura de enfermedades hasta la exploración espacial y la comprensión de la conciencia humana.

Sin embargo, también debemos ser conscientes de los riesgos y desafíos éticos que presentan. Será crucial desarrollar marcos regulatorios y éticos robustos para garantizar que estas poderosas tecnologías se utilicen de manera responsable y beneficiosa para toda la humanidad.

En conclusión, el futuro de la computación promete ser tan emocionante como desafiante. A medida que avanzamos en esta nueva frontera tecnológica, será fundamental mantener un equilibrio entre la innovación y la responsabilidad ética, asegurando que el próximo capítulo en la línea del tiempo de la historia de la computadora sea uno de progreso y beneficio para todos.

Preguntas frecuentes sobre la línea del tiempo de la historia de la computadora

¿Cuál fue la primera computadora electrónica? La primera computadora electrónica de propósito general fue ENIAC (Electronic Numerical Integrator and Computer), desarrollada en la Universidad de Pensilvania y presentada al público en 1946. Ocupaba una habitación entera y utilizaba miles de válvulas de vacío para realizar cálculos.

¿Cómo ha evolucionado el almacenamiento de datos en la historia de la computadora? El almacenamiento de datos ha evolucionado dramáticamente, desde las tarjetas perforadas y cintas magnéticas de las primeras computadoras, pasando por los discos duros y disquetes, hasta llegar a los modernos SSD y almacenamiento en la nube. La capacidad ha aumentado exponencialmente mientras que el tamaño físico se ha reducido.

¿Qué impacto tuvo el desarrollo del microprocesador? El desarrollo del microprocesador en la década de 1970 revolucionó la computación, permitiendo la creación de computadoras personales más pequeñas, potentes y asequibles. Esto llevó a la democratización de la tecnología y sentó las bases para la revolución digital.

¿Cómo ha cambiado Internet la forma en que usamos las computadoras? Internet ha transformado las computadoras de máquinas de procesamiento autónomas en nodos de una red global interconectada. Ha revolucionado la comunicación, el acceso a la información, el comercio, el entretenimiento y prácticamente todos los aspectos de la vida moderna.

¿Qué es la ley de Moore y cómo ha influido en la evolución de las computadoras? La ley de Moore, formulada por Gordon Moore en 1965, predice que el número de transistores en un circuito integrado se duplica aproximadamente cada dos años. Esta observación ha guiado la industria de los semiconductores, impulsando una mejora constante en el rendimiento y la eficiencia de las computadoras.

¿Cuál es la diferencia entre inteligencia artificial y machine learning? La inteligencia artificial es un campo más amplio que busca crear sistemas que puedan realizar tareas que normalmente requieren inteligencia humana. El machine learning es una subárea de la IA que se enfoca en desarrollar algoritmos que permiten a las computadoras aprender de los datos sin ser programadas explícitamente.

Conclusión: línea del tiempo de la historia de la computadora

La línea del tiempo de la historia de la computadora es un testimonio fascinante del ingenio humano y la innovación tecnológica. Desde las primeras máquinas de cálculo mecánicas hasta las modernas supercomputadoras y dispositivos móviles, cada generación ha traído avances significativos que han transformado nuestra sociedad de maneras profundas y duraderas.

Hemos recorrido un viaje extraordinario, desde los días en que las computadoras ocupaban habitaciones enteras y eran operadas por un puñado de expertos, hasta la actualidad, donde llevamos en nuestros bolsillos dispositivos más potentes que las computadoras que llevaron al hombre a la Luna. La historia de la computadora y sus generaciones no es solo una cronología de avances tecnológicos, sino también un relato de cómo estos avances han moldeado nuestra forma de vivir, trabajar y comunicarnos.

A lo largo de este viaje, hemos visto cómo la miniaturización, el aumento de la potencia de procesamiento y la conectividad global han ampliado enormemente las capacidades y aplicaciones de las computadoras. Desde el procesamiento de datos empresariales hasta la exploración espacial, desde la investigación médica hasta el entretenimiento, las computadoras se han convertido en herramientas indispensables en prácticamente todos los aspectos de la vida moderna.

Mirando hacia el futuro, tecnologías emergentes como la computación cuántica y la inteligencia artificial prometen abrir nuevas fronteras en la capacidad computacional y la resolución de problemas complejos. Estos avances tienen el potencial de abordar algunos de los desafíos más apremiantes de la humanidad, desde el cambio climático hasta la cura de enfermedades.

Sin embargo, con este gran poder vienen grandes responsabilidades. A medida que avanzamos hacia la próxima era de la computación, es crucial que consideremos cuidadosamente las implicaciones éticas y sociales de estas tecnologías. Debemos esforzarnos por garantizar que los beneficios de la revolución digital se distribuyan de manera equitativa y que se protejan los derechos y la privacidad de los individuos.

La historia de la computadora es, en última instancia, una historia de posibilidades. Cada avance ha ampliado los límites de lo que es posible, permitiéndonos soñar más grande y alcanzar más lejos. A medida que escribimos los próximos capítulos de esta historia, tenemos la oportunidad y la responsabilidad de dar forma a un futuro donde la tecnología sirva para mejorar la condición humana y expandir nuestro entendimiento del mundo y de nosotros mismos.

En conclusión, la línea del tiempo de la historia de la computadora es un recordatorio poderoso de lo lejos que hemos llegado y un indicador emocionante de lo mucho que queda por descubrir. A medida que continuamos innovando y explorando nuevas fronteras tecnológicas, podemos estar seguros de que el futuro de la computación será tan fascinante y transformador como su pasado.