- La combinación de DCGM, dcgm-exporter y Metricbeat permite monitorizar en detalle memoria, temperatura y rendimiento de GPU NVIDIA en Linux.

- Elastic Observability y Kibana facilitan analizar y visualizar métricas de GPU junto con CPU para detectar cuellos de botella y problemas de infraestructura.

- Ajustar auto boost, perfiles de energía y relojes de GPU es clave para lograr rendimiento estable y máximo tanto en centros de datos como en gaming.

- En Linux, las GPU NVIDIA de gama alta ofrecen mejor soporte y rendimiento que AMD, especialmente en juegos exigentes y cargas 4K.

Si trabajas con GPU de NVIDIA en Linux, tarde o temprano vas a necesitar entender qué está pasando con la memoria, el rendimiento y las estadísticas internas de tu sistema. Ya sea para juegos, para machine learning, para simulaciones científicas o para un centro de datos, controlar estos datos marca la diferencia entre un equipo que simplemente «funciona» y una plataforma realmente optimizada.

Al mismo tiempo, muchos usuarios llegan a Linux con la idea de que van a tener más rendimiento que en Windows con su GPU NVIDIA, pero luego se topan con benchmarks que no siempre muestran el resultado que esperaban. La clave está en saber monitorear, interpretar y afinar tanto el sistema operativo como la configuración de la GPU, aprovechando herramientas específicas como DCGM, dcgm-exporter, gpu-monitoring-tools y soluciones de observabilidad como Elastic.

Rendimiento de GPU NVIDIA en Linux: expectativas y realidad

Cuando alguien con una tarjeta moderna, por ejemplo una RTX 4070 u otras GPU de gama alta, se plantea cambiarse a Linux, es muy común que investigue en foros, Reddit, vídeos de YouTube y todo tipo de guías. Durante años se ha repetido la idea de que Linux siempre rinde mejor que Windows, pero la realidad, al mirar benchmarks serios y pruebas comparativas, es bastante más matizada.

En el terreno de los juegos, Linux ha mejorado muchísimo gracias a Steam, Proton y DXVK, que permiten ejecutar la mayoría de títulos de Windows en esta plataforma. Sin embargo, al revisar resultados en juegos exigentes, no siempre se consigue el mismo nivel de FPS que en Windows, especialmente cuando el juego no tiene versión nativa y depende de capas de compatibilidad.

Por otro lado, fuera del gaming, las GPU de NVIDIA se han convertido en la base de infraestructuras de alto rendimiento: entrenamiento de redes neuronales, simulaciones físicas complejas, renderizado y cargas de trabajo masivas en centros de datos. En ese contexto, controlar las estadísticas de memoria de Linux y exprimir la GPU de NVIDIA es crucial, y ahí es donde un buen sistema de monitoreo marca la diferencia.

Hay que tener en cuenta también que, en Linux, el rendimiento no depende solo de la GPU en sí, sino de la combinación entre drivers propietarios de NVIDIA, kernel, distribución elegida y configuración de energía y reloj de la tarjeta. Si cualquiera de estos elementos está mal ajustado, los benchmarks pueden mostrar resultados decepcionantes incluso con hardware muy potente.

Por qué es tan importante monitorear la GPU en Linux

Las GPU NVIDIA ya no son simplemente «tarjetas para jugar»; se han convertido en una pieza central en centros de datos, clouds públicas y entornos de cómputo intensivo. En muchos despliegues, la mayor parte de la capacidad de cálculo proviene de la GPU más que de la CPU, así que ignorar sus métricas de rendimiento es, directamente, un lujo que no se pueden permitir ni empresas ni usuarios avanzados.

En estos escenarios, no basta con saber cuánta memoria total tienes o qué modelo de GPU hay instalado. Es esencial poder ver en tiempo real uso de memoria, carga de GPU, temperatura, consumo energético, velocidad de los relojes y otros contadores internos que den pistas sobre cuellos de botella o problemas de estabilidad.

Además, Linux es el sistema operativo dominante en clusters de computación, HPC y plataformas de IA en la nube, por lo que toda la infraestructura de monitoreo suele girar en torno a él. NVIDIA ofrece su propio stack para exponer métricas, y soluciones como Elastic Observability permiten centralizar estos datos, visualizarlos y generar alertas inteligentes de forma bastante flexible.

Si estás usando GPU de NVIDIA en proveedores como Google Cloud, AWS o Genesis Cloud, el monitoreo no solo te ayuda a detectar errores; también te sirve para validar que lo que estás pagando en la nube se está utilizando de forma eficiente, evitando costes innecesarios por instancias infrautilizadas o mal configuradas.

Otro punto clave es que, a diferencia de la CPU, muchas métricas de GPU no están tan integradas en las herramientas clásicas de Linux. Por eso resultan especialmente útiles componentes como NVIDIA Datacenter GPU Manager (DCGM) y los exportadores de métricas específicos que se integran con sistemas de observabilidad modernos.

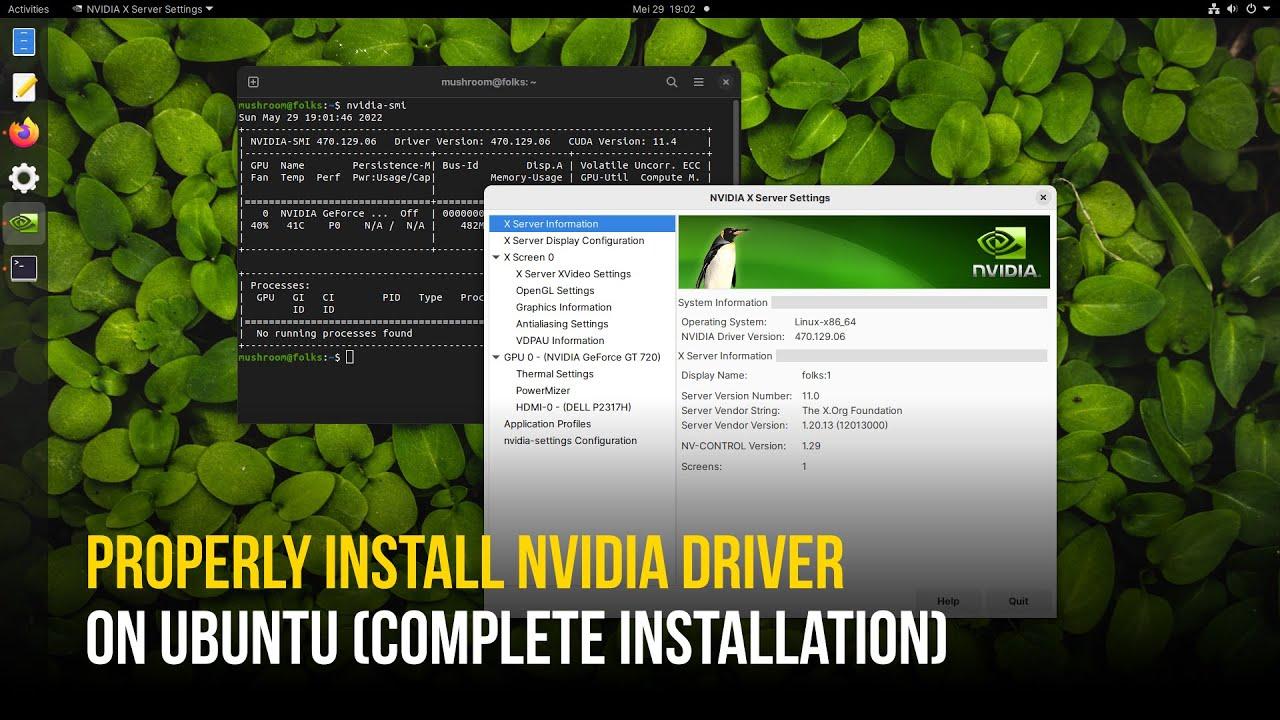

Dependencias básicas: drivers NVIDIA, DCGM y herramientas de monitoreo

Para tener estadísticas de memoria de Linux optimizadas en NVIDIA, el primer paso es contar con un entorno bien montado: drivers correctos, herramientas de GPU y una solución de observabilidad que recopile y visualice los datos. No sirve de nada querer gráficos bonitos si el sistema no es capaz de exponer las métricas de manera consistente.

En el entorno de centros de datos, NVIDIA proporciona Datacenter GPU Manager (DCGM), que actúa como la base para recopilar una gran variedad de métricas: desde uso de memoria y temperatura hasta información detallada de rendimiento interno. La instalación suele basarse en paquetes para distribuciones populares como Ubuntu 18.04 y otras versiones compatibles.

Durante el proceso de configuración descrito por NVIDIA, es importante fijarse en detalles como el parámetro <architecture> en los repositorios CUDA. Para sistemas de 64 bits típicos, el resultado del comando uname -a muestra que la arquitectura es x86_64, por lo que las líneas que se añaden al sistema de paquetes deben usar ese valor correctamente.

Un ejemplo típico para añadir el repositorio CUDA en una distro basada en Debian/Ubuntu sería algo como:

echo "deb http://developer.download.nvidia.com/compute/cuda/repos/$distribution/x86_64 /" | sudo tee /etc/apt/sources.list.d/cuda.list

También conviene revisar si la documentación tiene algún error tipográfico en los comandos oficiales, como el uso de un símbolo > extra al definir la variable $distribution en la línea donde se importan las claves GPG, que debe corregirse antes de ejecutar:

sudo apt-key adv --fetch-keys https://developer.download.nvidia.com/compute/cuda/repos/$distribution/x86_64/7fa2af80.pub

Una vez instalados los controladores y DCGM, podemos comprobar el estado básico de la GPU con la herramienta estándar nvidia-smi, que muestra modelo, memoria total y usada, temperatura y procesos que están haciendo uso de la tarjeta en ese momento.

Instalación de gpu-monitoring-tools y dcgm-exporter

Para integrar las estadísticas de memoria de Linux y de GPU NVIDIA con sistemas externos como Prometheus o Elastic, NVIDIA ofrece gpu-monitoring-tools, que incluyen el componente dcgm-exporter. Estas utilidades se distribuyen como código fuente en Go, por lo que necesitamos tener Golang instalado y correctamente configurado en el sistema.

En un escenario típico, se descarga e instala Go en /usr/local, extrayendo el archivo tar.gz y añadiendo el binario de Go al PATH. Después, se clona el repositorio oficial:

cd /tmp

git clone https://github.com/NVIDIA/gpu-monitoring-tools.git

cd gpu-monitoring-tools/

sudo env "PATH=$PATH:/usr/local/go/bin" make install

El componente clave en este paquete es dcgm-exporter, que se encarga de exponer las métricas de DCGM en un formato que puede entender Prometheus. Al levantarlo, se inicia un servidor HTTP que, por defecto, escucha en una dirección local como localhost:9090 y ofrece todas las métricas disponibles.

La configuración de qué estadísticas se van a exponer está definida en el archivo /etc/dcgm-exporter/default-counters.csv, que contiene decenas de contadores predefinidos. Entre ellos hay métricas relacionadas con memoria de GPU, temperatura, consumo de energía y varios indicadores internos de rendimiento. Si necesitas más granularidad, la documentación de la DCGM Library API detalla el listado completo de métricas que se pueden habilitar.

Al iniciar dcgm-exporter con un comando del estilo:

dcgm-exporter --address localhost:9090

verás mensajes de inicialización indicando que DCGM se ha iniciado correctamente. Es habitual recibir avisos sobre ciertos módulos no cargados, como las métricas DCP, que en este contexto pueden ignorarse sin mayor problema si no están siendo utilizados.

Integración con Elastic Observability mediante Metricbeat

Una vez que las métricas de GPU NVIDIA están expuestas vía dcgm-exporter, el siguiente paso lógico es enviar esos datos a una plataforma de observabilidad. Una opción muy potente es Elastic Observability, que aprovecha componentes como Metricbeat para recopilar métricas y centralizarlas en un despliegue de Elastic Cloud o en un stack autogestionado.

Para ello, primero se instala Metricbeat en el sistema Linux donde está corriendo dcgm-exporter. Se descarga el paquete .deb correspondiente a la versión más reciente, se instala con dpkg -i y se configura el archivo principal /etc/metricbeat/metricbeat.yml para que apunte al despliegue de Elastic Cloud mediante los parámetros cloud.id y cloud.auth.

El valor de cloud.id suele tener una forma codificada que identifica la región y el despliegue de Elastic, mientras que cloud.auth combina usuario y contraseña, por ejemplo:

cloud.id: "staging:dXMtY2VudHJhbDEuZ2NwLmNsb3VkLmVzLmlvJDM4ODZkYmUwMWNjODQ2NDM4YjRlNzg5OWEyZDAwNGM5JDBiMTc0YzYyMTVlYTQwYWQ5M2NmMGY4MjVhNzJmOGRk"

cloud.auth: "elastic:J7KYiDku2wP7DFr62zV4zL4y"

(obviamente, en un entorno real se usarán credenciales seguras propias del usuario).

Las entradas de Metricbeat son modulares, y en este caso necesitamos habilitar el módulo de Prometheus, ya que dcgm-exporter está publicando sus métricas siguiendo ese formato. La activación se hace con:

sudo metricbeat modules enable prometheus

Antes de ponerlo todo a funcionar, conviene ejecutar algunas pruebas de configuración para asegurarse de que Metricbeat está bien configurado y puede conectarse a Elastic Cloud y al endpoint de Prometheus. Para ello se usan comandos como:

sudo metricbeat test config

sudo metricbeat test output

sudo metricbeat modules list

Si estos tests fallan, lo recomendable es revisar la documentación de solución de problemas de Metricbeat, ya que los errores suelen estar relacionados con credenciales incorrectas, endpoints inaccesibles o módulos no habilitados correctamente. Una vez verificado todo, se puede ejecutar:

sudo metricbeat setup

para cargar dashboards por defecto y definir los mapeos de índices necesarios.

Finalmente, se inicia Metricbeat en modo de salida por consola, o como servicio, con:

sudo metricbeat -e

lo que hará que las métricas de GPU expuestas por dcgm-exporter empiecen a enviarse continuamente a Elastic, donde quedarán almacenadas y listas para ser analizadas.

Visualización de las métricas de memoria y GPU en Kibana

Una vez que los datos fluyen hacia Elastic Observability, llega la parte interesante: explorar, filtrar y cruzar métricas de GPU y CPU para entender de verdad qué está pasando en tu infraestructura. Para ello se utiliza principalmente Kibana, la interfaz web de análisis y visualización de Elastic.

El primer paso es asegurarse de que el patrón de índice metricbeat-* está correctamente configurado en la sección Stack Management > Kibana > Index Patterns. Desde ahí se selecciona dicho patrón y se pulsa en «Refresh field list» para que Kibana detecte los nuevos campos relacionados con las métricas de GPU.

Las métricas procedentes de dcgm-exporter y recogidas por el módulo de Prometheus suelen aparecer con un prefijo como prometheus.metrics.DCGM_. Entre esos campos se incluyen estadísticas de memoria utilizada, memoria libre, porcentaje de uso de GPU, temperaturas, consumo energético y otros indicadores relevantes.

Con estos campos ya disponibles, se puede utilizar la vista Discover de Kibana para realizar búsquedas ad hoc, filtrando por host, por nombre de GPU o por rango temporal. También es posible construir visualizaciones en la sección de dashboards, mostrando, por ejemplo, la evolución del uso de memoria de GPU a lo largo del día o comparando distintas instancias en un mismo gráfico.

Una de las vistas más prácticas es Metrics Explorer, que permite comparar el rendimiento de CPU y GPU en la misma pantalla. Esto ayuda a detectar patrones donde, por ejemplo, la GPU está al máximo mientras la CPU está infrautilizada, o al revés, señalando posibles problemas de equilibrio en la carga de trabajo.

Además, la vista de Inventory permite localizar puntos críticos de uso de GPU en grandes despliegues, identificando qué nodos están al límite, cuáles están ociosos y dónde se concentran los cuellos de botella. A partir de ahí se pueden definir alertas que se disparen cuando, por ejemplo, la memoria de la GPU supere cierto umbral durante un periodo de tiempo concreto.

Parámetros clave de monitoreo según NVIDIA

No todas las métricas tienen la misma relevancia a la hora de optimizar un entorno con GPU de NVIDIA en Linux. Según las recomendaciones del propio fabricante, hay algunos parámetros esenciales que conviene vigilar de forma continua para prevenir averías, detectar degradación de rendimiento y afinar el consumo energético.

La temperatura de la GPU es uno de los indicadores más evidentes. Un incremento sostenido por encima de rangos seguros puede indicar problemas de refrigeración, ventiladores sucios, flujo de aire deficiente en el chasis o incluso un diseño térmico insuficiente para la carga que se le está exigiendo al equipo.

Otra métrica fundamental es el consumo de energía de la GPU. Si una tarjeta empieza a consumir más energía de lo normal para una misma carga de trabajo, puede señalar problemas de hardware incipientes o una configuración de energía demasiado agresiva. En entornos de gran escala, este dato también es clave para controlar costes eléctricos y planificar la capacidad de la infraestructura.

Las velocidades actuales de los relojes (clocks) de la GPU también dicen mucho del estado del sistema. Si estos relojes se mantienen por debajo de los valores esperados durante una carga pesada, podría deberse a limitaciones de potencia, thermal throttling o ajustes de energía conservadores que están frenando el rendimiento real disponible.

Para pruebas de estrés o validación, NVIDIA ofrece herramientas como dcgmproftester10, que permiten simular cargas intensivas sobre la GPU y verificar cómo responden las métricas. Un comando típico sería:

dcgmproftester10 --no-dcgm-validation -t 1004 -d 30

que ejecuta un test de rendimiento concreto durante 30 segundos sin ciertas validaciones de DCGM, ideal para comprobar si el sistema se mantiene estable bajo presión.

Combinando estas métricas con las capacidades de alertas de Elastic, es posible automatizar recomendaciones sugeridas por NVIDIA, disparando notificaciones cuando se superan umbrales de temperatura, cuando la memoria se acerca peligrosamente al 100 % de uso o cuando el consumo energético se desmadra notablemente frente a las referencias habituales.

Optimización de la configuración de GPU NVIDIA en Linux

Más allá del monitoreo pasivo, hay una serie de ajustes que se pueden aplicar en Linux para obtener un rendimiento más estable y, en muchos casos, superior con las GPU de NVIDIA. Uno de los aspectos más relevantes es la gestión de las funciones de auto-boost y escalado dinámico de reloj que trae el propio driver.

En algunos tipos de instancias de GPU, el controlador NVIDIA utiliza una característica de aumento automático de potencia (auto boost) que ajusta las frecuencias de la GPU según la carga y las condiciones térmicas. Aunque esto es útil para entornos generales, en escenarios donde se requiere máximas prestaciones y repetibilidad en los resultados, puede ser preferible desactivar estas funciones y fijar manualmente las velocidades de reloj en sus valores máximos seguros.

Al desactivar el auto boost y fijar las frecuencias máximas, se consigue que el rendimiento sea mucho más uniforme y predecible entre ejecuciones. Es especialmente importante en entornos de benchmarking, validación de hardware, centros de datos y plataformas de IA donde interesa que la variación entre runs sea mínima.

Otro punto a vigilar es el modo de energía en el que está configurada la GPU. En Linux, a través de las herramientas de NVIDIA, se pueden ajustar perfiles de potencia que van desde modos más ahorradores hasta modos de máximo rendimiento persistente. Seleccionar un perfil demasiado conservador puede limitar notablemente los FPS en juegos o el rendimiento en cómputo intensivo, aunque a cambio se reduzca el consumo.

En equipos de usuario, especialmente aquellos destinados a jugar en Linux con tarjetas modernas, es buena idea revisar que los drivers estén al día y que las opciones de persistence mode, límite de potencia y perfil de reloj estén alineadas con el objetivo de rendimiento que se busca. Es un área donde muchos benchmarks negativos se explican simplemente por una configuración poco optimizada de fábrica.

Linux y juegos con GPU NVIDIA: situación actual

Aunque todavía se arrastra la fama de que Linux no es «la plataforma adecuada» para jugar, la realidad es que, con una buena GPU NVIDIA y el ecosistema de Steam, es perfectamente viable disfrutar de muchos títulos con una experiencia bastante cercana a la de Windows, sobre todo si se aprovechan las APIs gráficas modernas.

Steam Play, mediante Proton y DXVK (un fork específico de Wine), se encarga de traducir las llamadas de DirectX a Vulkan, permitiendo ejecutar una gran cantidad de juegos originalmente desarrollados para Windows. No siempre se alcanza el rendimiento nativo exacto, pero la pérdida de FPS suele ser contenida y, en muchos casos, aceptable para la mayoría de usuarios.

En comparativas realizadas con tarjetas de generaciones anteriores, desde NVIDIA GeForce GTX 980 Ti hasta TITAN RTX, y modelos de AMD como Radeon RX Vega 56 o Radeon VII, se ha visto que las GPU de gama alta de NVIDIA con núcleos Turing destacan especialmente en resolución 4K sobre Linux cuando se trata de juegos exigentes.

Un ejemplo ilustrativo lo encontramos en juegos como Total War: Three Kingdoms, donde muchas de las 18 tarjetas probadas pueden alcanzar los deseados 60 FPS a 4K si se mantiene un nivel de detalle bajo. Al subir el detalle a medio, solo modelos muy potentes como la RTX 2080 Ti o la TITAN RTX son capaces de superar de forma consistente esa barrera en Linux.

Otros títulos como Counter-Strike: Global Offensive o DOTA 2 muestran un comportamiento mucho más amable: aprovechando la API Vulkan cuando está disponible, prácticamente todas las tarjetas probadas pueden moverlos sin complicaciones a 4K, con altas tasas de FPS incluso en hardware no tan puntero dentro del rango analizado.

En juegos algo más pesados gráficamente como Deus Ex: Mankind Divided o Dawn of War III, vuelve a quedar patente la necesidad de contar con tarjetas de gama alta si se pretende jugar a 4K con detalles altos. En títulos como Rise of the Tomb Raider o A Total War Saga: Thrones of Britannia, la mayoría de GPU pueden con la resolución 4K si se ajusta el nivel de detalle a valores bajos o medios, lo que refuerza la idea de que NVIDIA lleva ventaja en drivers y optimización para Linux en estos escenarios frente a AMD.

Un aspecto que se repite en estas pruebas es que AMD todavía tiene margen de mejora en drivers para Linux orientados a gaming, mientras que NVIDIA ofrece un soporte más maduro y actualizaciones más consistentes. Para quienes buscan el mejor rendimiento posible en juegos de alta resolución dentro de Linux, esto sigue siendo un factor determinante a la hora de escoger GPU.

En conjunto, entender cómo se comportan las estadísticas de memoria de Linux y las métricas de GPU de NVIDIA, combinadas con una buena configuración de drivers y herramientas de monitoreo, permite sacar mucho más jugo a la tarjeta, ya sea en un PC de juegos, en un servidor de IA o en un centro de datos con decenas de nodos trabajando a pleno rendimiento.

Queda claro que controlar de forma detallada la memoria, el rendimiento y el estado de las GPU NVIDIA en Linux ya no es algo opcional, sino una pieza clave tanto para entornos de producción como para usuarios exigentes: un buen stack de drivers y DCGM, una capa de exportación de métricas con dcgm-exporter, la recolección con Metricbeat y la visualización en Kibana, unidos a ajustes finos de potencia y reloj de la GPU, son lo que realmente marca la diferencia entre un sistema que simplemente cumple y uno que exprime al máximo cada vatio y cada giga de memoria disponible.

Tabla de Contenidos

- Rendimiento de GPU NVIDIA en Linux: expectativas y realidad

- Por qué es tan importante monitorear la GPU en Linux

- Dependencias básicas: drivers NVIDIA, DCGM y herramientas de monitoreo

- Instalación de gpu-monitoring-tools y dcgm-exporter

- Integración con Elastic Observability mediante Metricbeat

- Visualización de las métricas de memoria y GPU en Kibana

- Parámetros clave de monitoreo según NVIDIA

- Optimización de la configuración de GPU NVIDIA en Linux

- Linux y juegos con GPU NVIDIA: situación actual