- Google TPU v7 Ironwood es la séptima generación de TPUs y está diseñada específicamente para la era de la inferencia, con 4.614 TFLOPs FP8 y 192 GB de HBM3e por chip.

- La arquitectura escala hasta 9.216 chips en un superpod con 1,77 PB de memoria compartida, redes ICI de 9,6 Tb/s y refrigeración líquida optimizada para casi 10 MW.

- Integrada en AI Hypercomputer junto con CPUs Axion, Ironwood ofrece un fuerte equilibrio entre rendimiento, eficiencia energética y costes para cargas masivas de IA.

- El megacontrato con Anthropic y la estrategia de integración vertical refuerzan el papel de Google como competidor clave frente a Nvidia en el mercado de chips de IA.

La aceleración de la inteligencia artificial está viviendo un cambio de etapa. Ya no basta con entrenar modelos gigantes y presumir de parámetros: ahora la batalla real está en cómo hacerlos funcionar a diario, para millones de usuarios, sin que los costes energéticos y de infraestructura de IA se disparen. En ese contexto aparece Google TPU v7 Ironwood, una pieza de hardware pensada para una IA que no solo responde, sino que piensa, razona y actúa de forma continua.

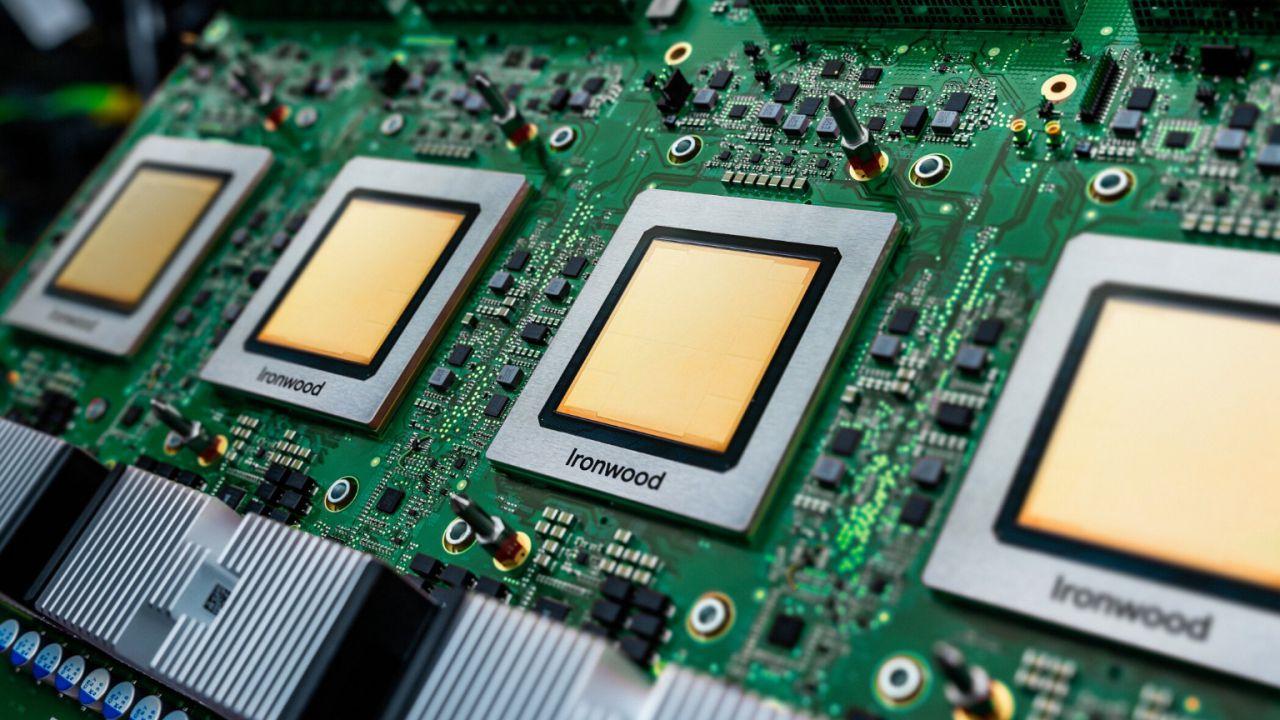

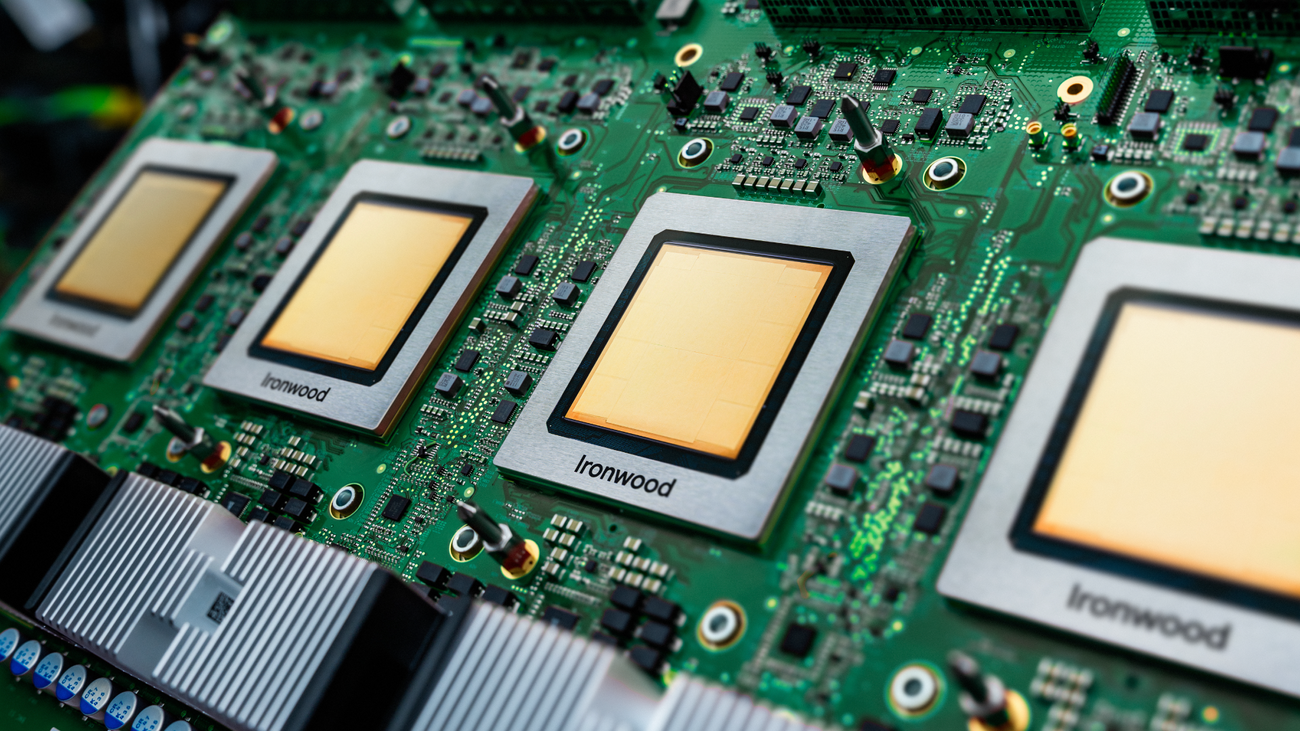

Ironwood es la séptima generación de las Tensor Processing Units (TPU) de Google y, según la propia compañía, su chip más potente, escalable y eficiente hasta la fecha. Está diseñado para la llamada “era de la inferencia”, donde lo importante no es tanto cuánto tardas en entrenar un modelo nuevo, sino cuánto te cuesta servirlo, mantenerlo activo, razonando y generando resultados a todas horas. Vamos a ver con calma qué es exactamente Google TPU v7 Ironwood, qué tiene de especial y por qué está agitando el tablero frente a Nvidia y el resto de gigantes del sector.

Qué es Google TPU v7 Ironwood y por qué es tan importante

Ironwood es, en esencia, un acelerador de IA hecho a medida por Google para ejecutar modelos de inteligencia artificial de última generación. Forma parte de la familia de Tensor Processing Units (TPU), chips específicos para cargas de trabajo de aprendizaje automático que llevan casi una década impulsando servicios internos de Google (búsqueda, YouTube, publicidad, traducción, etc.) y, más recientemente, las soluciones de Google Cloud.

Esta séptima generación se ha construido partiendo de toda la experiencia acumulada con TPUs anteriores y con un objetivo claro: maximizar el rendimiento en inferencia y en tareas de razonamiento complejo, sin renunciar a la capacidad de entrenamiento. Modelos de lenguaje extenso (LLM), mezclas de expertos (Mixture of Experts), sistemas de recuperación aumentada y agentes de IA que necesitan mantener mucho contexto en memoria son el tipo de cargas para las que Ironwood está pensada.

En lugar de limitarse a ser “un chip más rápido”, Ironwood se integra dentro de la arquitectura AI Hypercomputer de Google Cloud, un enfoque donde computación, red, almacenamiento y software se diseñan de forma conjunta. Eso permite ajustar desde el silicio hasta el orquestador de contenedores para exprimir cada vatio y cada ciclo de reloj.

Otro punto clave es que Ironwood es la primera TPU diseñada desde cero para la era de la inferencia. Hasta ahora, la mayoría de sistemas de IA estaban pensados sobre todo para entrenar modelos enormes; ahora el foco se traslada a ejecutar esos modelos una y otra vez, de forma eficiente, con agentes que no solo reaccionan, sino que anticipan, buscan datos, los combinan y devuelven conclusiones.

Características técnicas clave de TPU v7 Ironwood

En el plano técnico, Ironwood viene cargada de cifras que impresionan incluso en un mercado tan competitivo como el de los chips de IA. Cada chip ofrece 4.614 teraflops de potencia en precisión FP8, lo que supone más de 16 veces la capacidad de cómputo de la TPU v4 y un salto enorme respecto a generaciones previas.

Para alimentar semejante potencia, cada chip integra 192 GB de memoria HBM3e de última generación, con un ancho de banda aproximado de 7,3-7,4 TB/s. Esta combinación de cómputo y memoria de alta velocidad es precisamente lo que hace posible manejar modelos gigantescos y contextos muy largos sin ahogarse en cuellos de botella.

Ironwood está fabricada con un proceso avanzado de 5 nanómetros y tiene un consumo aproximado de 600 vatios por chip. Puede sonar elevado, pero si lo comparas con el rendimiento que ofrece por cada vatio consumido, el resultado es muy competitivo: frente a la generación anterior Trillium (TPU v6e), Ironwood dobla el rendimiento por vatio.

Estas mejoras se notan tanto en cargas de entrenamiento como de servicio. Para entrenar, Ironwood puede acelerar el proceso de modelos de nueva generación (como Gemini o Veo) y de otros proveedores, y para servir, permite ejecutar inferencias masivas con menor coste energético, algo crítico ahora que los centros de datos de IA se miden en gigavatios.

De chip a Superpod: cómo escala Ironwood

La verdadera magia de Ironwood no está solo en un chip aislado, sino en cómo se escala hasta formar superordenadores de IA. Cada SoC Ironwood se monta en una placa (PCBA) con cuatro chips y cada rack integra 16 de estas placas, lo que da un total de 64 chips por rack.

A partir de ahí, los racks se agrupan para formar un Superpod Ironwood. Un superpod completo incluye 144 racks, lo que equivale a 9.216 chips conectados entre sí. En conjunto, esto se traduce en alrededor de 42,5 exaflops de rendimiento FP8 y una memoria HBM compartida de unos 1,77 petabytes, todo ello accesible como un gran recurso lógico para los modelos de IA.

La interconexión entre chips se realiza mediante la red Inter-Chip Interconnect (ICI), con un diseño en 3D Torus (4x4x4) y velocidades de hasta 9,6 Tb/s. Esta topología permite reducir la latencia y mantener altas tasas de transferencia incluso cuando el sistema escala a miles de aceleradores, algo fundamental para el entrenamiento distribuido y para cargas de inferencia altamente paralelas.

Más allá del superpod, la infraestructura se puede extender todavía más combinando bloques de 64 chips conectados y enlazándolos mediante un backbone óptico de hasta 1,8 PB/s. Esta mezcla de cables de cobre pasivos, fibra óptica y conmutadores ópticos da una enorme flexibilidad a la hora de configurar clústeres a medida para diferentes clientes y modelos.

En términos de potencia, un despliegue de este tamaño se acerca a los 10 megavatios de capacidad eléctrica, una cifra que obliga a tomarse muy en serio la refrigeración y la eficiencia. Cada rack está preparado para superar los 100 kW de consumo, por lo que todo el sistema se ha diseñado desde el inicio para refrigeración líquida y distribución avanzada de energía.

Refrigeración, consumo y eficiencia energética

Con densidades de potencia tan bestias, la pregunta obvia es: ¿cómo mantiene Google todo esto bajo control térmico? La respuesta está en un sistema de refrigeración líquida de última generación, diseñado específicamente para los superpods Ironwood.

Cada rack integra un circuito de distribución de refrigerante (CBU) con detectores de fugas y redundancia eléctrica a 416V AC. Esta configuración no solo evita sobrecalentamientos, sino que también proporciona una alta fiabilidad para cargas de trabajo críticas de IA, donde una interrupción prolongada puede suponer millones de euros perdidos o interrupciones de servicio a gran escala.

Ironwood no busca simplemente ser el sistema más potente, sino también uno de los más eficientes. Frente a Trillium, la TPU v7 consigue el doble de rendimiento por cada vatio consumido. Eso significa que, con el mismo presupuesto energético de 2024, un centro de datos equipado con Ironwood podría servir hasta el doble de inferencias en 2026.

Este enfoque responde a una realidad incómoda del sector: la energía, no el silicio, se está convirtiendo en el factor limitante para la expansión de la IA. Las redes eléctricas de muchos países empiezan a rozar su capacidad en zonas clave para centros de datos, por lo que exprimir más trabajo útil de cada vatio ya no es una ventaja, es una necesidad.

Además, la arquitectura de Ironwood está optimizada para reducir al mínimo el movimiento de datos innecesario, uno de los grandes consumidores de energía en sistemas distribuidos. La combinación de memoria HBM masiva y redes de alta velocidad busca precisamente eso: más trabajo cerca de los datos y menos viajes caros por el centro de datos.

Ironwood dentro de AI Hypercomputer y la capa de software

Ironwood no vive aislada; está profundamente integrada en la arquitectura AI Hypercomputer de Google Cloud. Este concepto agrupa en un mismo marco de diseño el hardware (TPUs y CPUs Axion), la red de alta velocidad, el almacenamiento y el software de orquestación y programación.

En la capa de software, Google apuesta por su pila Pathways, que permite coordinar decenas de miles de TPUs Ironwood como si fueran un único recurso lógico. Junto a Pathways, se han reforzado herramientas como MaxText (para entrenamiento de LLMs a gran escala) y la integración con Kubernetes Engine mediante Cluster Director, que optimiza la programación y la resiliencia de los clústeres.

Para la parte de inferencia, Google ha extendido el soporte de vLLM para trabajar tanto con GPU como con TPU, haciendo más sencillo migrar modelos y cargas entre distintos tipos de aceleradores con cambios mínimos en el código. Además, GKE Inference Gateway puede reducir la latencia inicial de las peticiones hasta en un 96% y rebajar el coste de servicio entorno a un 30%, según datos compartidos por la compañía.

Todo esto se traduce en que los clientes no solo acceden a un chip rápido, sino a una plataforma completa optimizada extremo a extremo. IDC, de hecho, cita retornos de inversión del 353% en tres años para clientes de AI Hypercomputer, con reducciones en costes de TI de cerca del 28%.

El objetivo final es claro: que las empresas puedan aprovechar la potencia de Ironwood sin volverse locas gestionando infraestructuras complejas. El usuario ideal simplemente define sus modelos y necesidades, y el plano de control de Google Cloud se encarga de orquestar TPUs, Axion, red, almacenamiento y software de forma transparente.

La “era de la inferencia” y el papel de Ironwood

Durante años, gran parte del discurso en IA giraba en torno a entrenar modelos cada vez más grandes. Sin embargo, el mercado se ha dado de bruces con una realidad: por muy espectacular que sea el entrenamiento, los ingresos sostenidos vienen de servir inferencias a escala, día sí y día sí.

Google habla de la “era de la inferencia” para referirse a este nuevo momento. En lugar de modelos meramente reactivos, que esperan a que el usuario pregunte, estamos pasando a agentes de IA que recuperan datos, analizan contextos, coordinan subprocesos y toman la iniciativa para ofrecer recomendaciones e información procesada.

Ironwood está diseñada justo para este tipo de cargas: modelos con razonamiento complejo, contextos extensos y estados persistentes. La gran cantidad de memoria compartida y el ancho de banda de red están pensados para que múltiples componentes de un mismo sistema de IA trabajen de forma coordinada sin ahogarse en tráfico.

En este panorama, Google adopta una estrategia distinta a la de Nvidia. Mientras los chips Blackwell siguen dominando el entrenamiento de vanguardia y prometen velocidades de inferencia muy altas en configuraciones concretas, Google se centra en optimizar la ejecución continua y masiva de modelos en producción, integrando hardware y nube en un único paquete coherente.

La compañía no pretende reemplazar a Nvidia en todos los frentes, sino capturar una porción creciente del mercado total de inferencia. Algunas estimaciones internas hablan de que, para 2027, las TPUs de Google podrían representar hasta un 30% de ese mercado, especialmente en grandes clientes que ya están anclados en Google Cloud.

El acuerdo con Anthropic y el impulso comercial

El gran espaldarazo comercial de Ironwood ha llegado de la mano de Anthropic, desarrollador de los modelos Claude. El 23 de octubre de 2025, la compañía firmó un acuerdo masivo con Google, comprometiéndose a utilizar hasta un millón de TPUs y a invertir decenas de miles de millones de dólares en infraestructura sobre Google Cloud.

Este contrato prevé un consumo energético superior a 1 gigavatio para 2026, una barbaridad que da una idea de la escala a la que se están moviendo los grandes actores de la IA. De la noche a la mañana, Ironwood pasó de ser un proyecto ambicioso en la hoja de ruta a convertirse en una apuesta real respaldada por demanda firme.

Para Google, el acuerdo resuelve uno de los grandes temores: construir capacidad de centros de datos sin tener garantizado su uso. Con Anthropic como cliente ancla, la empresa puede planificar nuevas instalaciones, contratos de energía y despliegues de superpods Ironwood con mucha más visibilidad sobre el retorno.

Que Anthropic haya optado por Ironwood, en lugar de esperar a la siguiente generación de Nvidia o recurrir a hardware propietario de otros hiperescaladores, es una señal clara de la confianza en la eficiencia y el time-to-market de las TPUs de Google. “Más inferencia, menos energía” es, en la práctica, el lema implícito de este movimiento.

Este tipo de acuerdos a largo plazo ayuda también a Google a negociar mejor sus propios costes (desde fabricación de chips hasta suministro energético) y refuerza su posición en un mercado donde la demanda de cómputo de IA supera con creces la oferta disponible.

Impacto en el mercado de chips de IA y competencia con Nvidia

El lanzamiento de Ironwood supone un golpe sobre la mesa en el mercado de hardware de IA, hasta ahora dominado de forma muy clara por las GPU de Nvidia. Google no es el único que está moviendo ficha: AWS impulsa su línea Trainium2 y Microsoft progresa con su programa Maia, aunque con retrasos.

Nvidia sigue liderando la parte de entrenamiento puntero, con sus arquitecturas Hopper, Blackwell y la futura Rubin, que apuntan a configuraciones de varios exaflops por rack. Sin embargo, Google está empujando el mercado hacia un modelo de varios ecosistemas integrados verticalmente, donde cada hiperescalador diseña sus propios chips, red, software y servicios de nube.

En este nuevo escenario, Ironwood se posiciona como alternativa sólida para empresas que buscan infraestructura de inferencia a gran escala sin depender al 100% del ecosistema CUDA. La combinación de TPUs personalizadas y CPUs Axion, más la nube de Google Cloud, conforma una oferta muy atractiva para compañías que necesitan previsibilidad de costes, rendimiento y disponibilidad.

El movimiento también añade presión a Nvidia, que debe justificar precios elevados en un entorno donde ya no es la única opción viable. A medida que Amazon, Microsoft y Google refuerzan sus pilas propias, el mercado se aleja del modelo de proveedor único de chips hacia un mosaico de soluciones cerradas, pero muy optimizadas, dentro de cada nube.

Eso sí, el éxito de Ironwood y de las TPUs en general dependerá mucho de que la pila de software de Google siga madurando al ritmo del ecosistema CUDA. Si las tasas de utilización de los clústeres bajan (por ejemplo, de un 90% a un 70%), la eficiencia global se resiente y la competitividad en precio podría verse afectada.

Axion: el complemento CPU para la infraestructura de IA

En paralelo al lanzamiento de Ironwood, Google ha reforzado su familia de CPUs personalizadas Axion, basadas en arquitectura Arm Neoverse. Mientras las TPUs se encargan de la parte más pesada del aprendizaje automático, Axion se ocupa de las cargas de propósito general que rodean a la IA.

Las nuevas instancias N4A ofrecen hasta 64 vCPU, 512 GB de memoria DDR5 y 50 Gbps de red, con mejoras de hasta el 100% en relación precio-rendimiento frente a máquinas x86 equivalentes. Por su parte, C4A metal es la primera versión bare-metal basada en Arm de Google Cloud, orientada a escenarios como desarrollo Android, automoción o simulaciones avanzadas.

Empresas como Vimeo han reportado mejoras del 30% en transcodificación de vídeo, mientras que ZoomInfo habla de un 60% más de eficiencia en procesos de análisis de datos. Otras compañías, como Rise, aseguran haber reducido alrededor de un 20% el consumo de computación, manteniendo latencias estables.

La idea de fondo es que Axion actúe como capa base de cómputo general: preparación de datos, microservicios, servicios web, lógica de negocio, etc. Sobre ese cimiento, las TPUs Ironwood se centran en lo que mejor se les da: acelerar el entrenamiento, la inferencia y el razonamiento de modelos de IA.

Este tándem refuerza la visión de que la computación de próxima generación será híbrida: CPUs eficientes para gestionar el flujo y TPUs (u otros aceleradores) para el cálculo intensivo. Todo ello, cohesionado por la plataforma AI Hypercomputer y las herramientas de Google Cloud.

Perspectiva de inversión y protección de márgenes para Alphabet

Desde el punto de vista financiero, Ironwood es mucho más que un chip potente: es una pieza estratégica para proteger los márgenes de Alphabet en el negocio de la IA en la nube. Los hiperescaladores se encaminan hacia capacidades de energía de doble dígito en gigavatios para 2027 y todo indica que la inversión en infraestructura seguirá siendo brutal.

Al diseñar sus propios chips, Google puede capturar valor a lo largo de toda la cadena: desde la concepción del silicio hasta su explotación en la nube. En lugar de revender hardware de terceros con márgenes ajustados, convierte el CAPEX en una ventaja competitiva y en una herramienta para diferenciar sus servicios.

La mejora en rendimiento por vatio de Ironwood significa que cada megavatio de capacidad de centro de datos rinde mucho más en términos de inferencias servidas. Si lo combinamos con optimizaciones de software (vLLM, Pathways, GKE Inference Gateway, etc.), Google puede ofrecer precios agresivos sin destrozar su rentabilidad.

El contrato con Anthropic añade un componente extra de estabilidad al plan de gasto de capital de Google. En vez de construir infraestructuras “a ciegas” esperando que los clientes lleguen, ahora puede dimensionar gran parte de su expansión en función de acuerdos a largo plazo, reduciendo la incertidumbre y el riesgo de sobrecapacidad.

Aun así, persisten preguntas abiertas: si Google logrará atraer más clientes ancla de gran tamaño, si los proyectos de energía y nuevas subestaciones irán en plazo y si su stack de software mantendrá tasas de utilización altas. El potencial está ahí, pero la ejecución será clave para que Ironwood sea tanto un éxito técnico como un motor de beneficios sostenidos. NO ES ASESORAMIENTO DE INVERSIÓN.

En conjunto, Google TPU v7 Ironwood se presenta como un salto generacional que va mucho más allá de los teraflops en una ficha técnica: combina potencia bruta, memoria compartida masiva, redes ópticas avanzadas, refrigeración líquida y una nube profundamente integrada para sostener la nueva ola de agentes y modelos de IA que funcionan a todas horas. En un mundo donde la energía aprieta, los modelos crecen sin parar y la competencia por el control del stack de IA es feroz, Ironwood se perfila como el corazón de una infraestructura pensada para dar vida a la “era de la inferencia” y para redefinir cómo, dónde y a qué coste se ejecuta la inteligencia artificial a escala planetaria.

Tabla de Contenidos

- Qué es Google TPU v7 Ironwood y por qué es tan importante

- Características técnicas clave de TPU v7 Ironwood

- De chip a Superpod: cómo escala Ironwood

- Refrigeración, consumo y eficiencia energética

- Ironwood dentro de AI Hypercomputer y la capa de software

- La “era de la inferencia” y el papel de Ironwood

- El acuerdo con Anthropic y el impulso comercial

- Impacto en el mercado de chips de IA y competencia con Nvidia

- Axion: el complemento CPU para la infraestructura de IA

- Perspectiva de inversión y protección de márgenes para Alphabet